Métodos estadísticos descriptivos y de aprendizaje automático para las finanzas

Métodos estadísticos descriptivos y de aprendizaje automático para las finanzas

Rolando Wilber Ordoñez Neyra, Beto Puma Huamán, Edgardo Martin Figueroa Donayre, Rogger Humpiri Flores, Hector Ito Mamani, Cesar Eusebio Pacori Mamani

© Rolando Wilber Ordoñez Neyra, Beto Puma Huamán, Edgardo Martin Figueroa Donayre. Rogger Humpiri Flores, Hector Ito Mamani, Cesar Eusebio Pacori Mamani

Primera edición: Julio, 2024

Editado por:

Editorial Mar Caribe

Av. General Flores 547, Colonia, Colonia-Uruguay.

RUC: 15605646601

Diseño de cubierta: Yelitza Sánchez Cáceres

Libro electrónico disponible en https://editorialmarcaribe.es/?page_id=805

Formato: electrónico

ISBN: 978-9915-9682-2-3

Hecho el Depósito Legal en la Biblioteca Nacional de Uruguay N°.: 385.374

Aviso de derechos de atribución no comercial: Los autores pueden autorizar al público en general a reutilizar sus obras únicamente con fines no lucrativos, los lectores pueden usar una obra para generar otra obra, siempre y cuando se dé el crédito de investigación y, otorgan a la editorial el derecho de publicar primero su ensayo bajo los términos de la licencia CC BY-NC 4.0.

Índice

El Machine Learning en las finanzas

Aplicaciones en el sistema financiero

Las ventajas ML en el sistema financiero

Análisis descriptivo en el aprendizaje automático

El análisis exploratorio de los datos

Los datos categóricos: cualitativos

El procesamiento de datos en la computadora

La estrategia en el análisis de datos con el empleo de programas de computación

Los malos hábitos en el empleo de la computadora

Gráficos en la estadística descriptiva

Los otros modelos de aprendizaje no supervisado

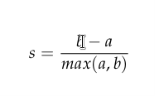

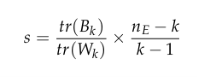

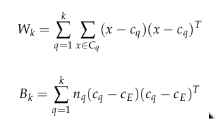

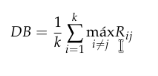

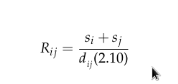

Los coeficientes de evaluación

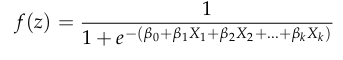

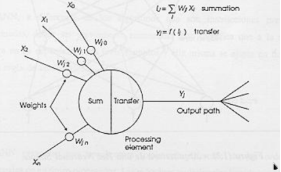

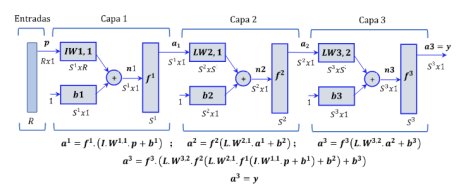

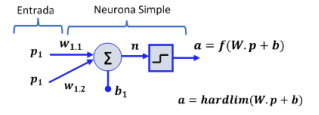

Procesamiento: las entradas y las salidas

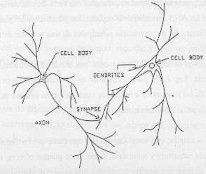

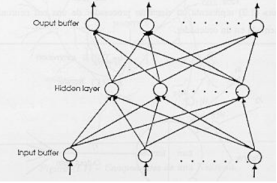

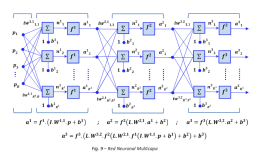

Las redes neuronales y los sistemas adaptativos

Los filtros adaptativos de redes neuronales

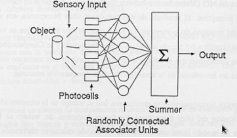

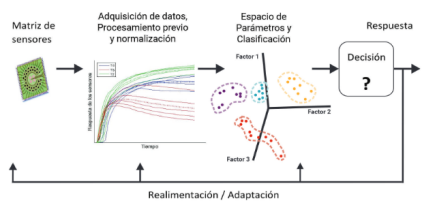

El reconocimiento estadístico de patrones: redes neuronales

Descripción del reconocimiento

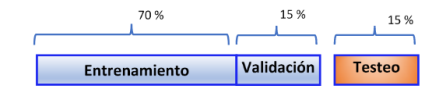

Los datos de entrenamiento: validación y de testeo

El reconocimiento estadístico de los patrones

Las técnicas de reconocimiento de patrones

El aprendizaje y la generalización

La evaluación de la generalización

El entrenamiento y la generalización

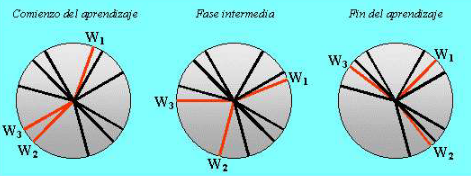

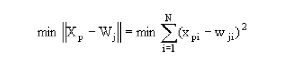

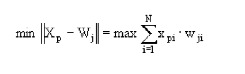

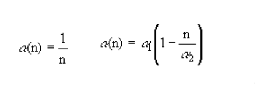

La redes neuronales con mapas autoorganizados

Las redes neuronales dinámicas

El aprendizaje automático cae bajo el paraguas de la ciencia de datos e implica la utilización de modelos estadísticos para extraer información y hacer pronósticos, y presenta la ventaja de adquirir conocimientos a través de la experiencia en lugar de depender de una programación explícita. Su función consiste en seleccionar modelos adecuados y proporcionarles datos, lo que en última instancia lleva a que el modelo ajuste sus parámetros de forma autónoma para mejorar su rendimiento.

Los especialistas en análisis de datos se dedican a la formación de modelos de aprendizaje automático utilizando conjuntos de datos existentes. Posteriormente utilizan estos modelos en escenarios prácticos. El modelo se inicia como un proceso que se ejecuta en segundo plano y tiene la capacidad de generar resultados automáticamente según su configuración. Dependiendo de los requisitos específicos de una empresa, los modelos se pueden entrenar periódicamente para garantizar que se mantengan actualizados. Algunas empresas pueden incluso actualizar sus modelos diariamente, aunque esta frecuencia puede variar en función del volumen de datos recopilados.

En el ámbito del aprendizaje automático, se entiende ampliamente que la precisión de los resultados es directamente proporcional al volumen de datos incorporados al modelo. Afortunadamente, el sector financiero cuenta con una amplia gama de datos que abarcan multitud de facetas, incluidos varios tipos de transacciones, información del cliente, detalles de facturas y mucho más. En consecuencia, es inequívoco que los datos desempeñan un papel insustituible en el ámbito del aprendizaje automático dentro de la industria financiera.

El rápido ritmo de los avances tecnológicos evoluciona constantemente y, al mismo tiempo, la cantidad de información que se genera crece exponencialmente. Estos factores combinados indican que, en el futuro cercano, las aplicaciones potenciales del aprendizaje automático en el ámbito de los servicios financieros serán cada vez más imperceptibles y aparentemente inalcanzables. Sin embargo, la mayoría de las instituciones financieras aún no están preparadas para aprovechar plenamente el inmenso potencial de esta tecnología. ¿Cuáles son las razones detrás de esta falta de preparación?

- Muchas empresas no comprenden del todo las verdaderas ventajas que puede aportar el aprendizaje automático.

- La investigación y el desarrollo de tecnología de aprendizaje automático a menudo pueden generar costes elevados.

- Actualmente, hay escasez de personas capacitadas en los campos del aprendizaje automático y la ingeniería de inteligencia artificial.

- Los administradores de instituciones financieras suelen ser personas con aversión al riesgo y cautelosas a la hora de tomar decisiones que pueden tener posibles consecuencias negativas. Además, tienden a ser lentos a la hora de implementar cambios y actualizar su infraestructura de datos, y a menudo toman una cantidad de tiempo considerable antes de adoptar nuevas tecnologías o sistemas.

Un número limitado de empresas ha adoptado la adopción de técnicas de aprendizaje automático en sus operaciones. Si bien, las empresas que han implementado con éxito esta tecnología han experimentado innumerables ventajas notables. Una de esas ventajas es la reducción significativa de los costes operativos, atribuida principalmente a la automatización de diversos procesos. Asimismo, estas empresas han observado un aumento sustancial en la generación de ingresos, que puede atribuirse a mayores niveles de productividad y una mejor experiencia de usuario. Además, la implementación del aprendizaje automático también ha reforzado las medidas de seguridad empleadas por estas empresas, fortaleciendo así sus defensas contra posibles amenazas cibernéticas.

Capítulo 1

El Machine Learning en las finanzas

Nos encontramos en una era intrigante de la tecnología, donde los constantes avances y descubrimientos descubren continuamente el inmenso potencial de cada innovación. Todo comenzó en agosto de 1981, cuando IBM presentó la primera computadora personal del mundo, inicialmente diseñada para mejorar los lanzamientos balísticos, pero que finalmente condujo al desarrollo de muchas otras aplicaciones que han transformado profundamente nuestra sociedad. A medida que se desarrollaba la tercera revolución industrial, la llegada de Internet impulsó la importancia de los teléfonos móviles como dispositivos personales para gestionar información y acceder a una gran cantidad de servicios, incluidos los financieros. Sin embargo, el futuro presenta perspectivas aún más prometedoras con la aparición de la computación cuántica. En un logro innovador anunciado por Google en octubre de 2019, realizaron con éxito un cálculo de números aleatorios en apenas tres minutos y veinte segundos, una tarea que a las computadoras tradicionales más potentes de la actualidad les habría llevado miles de años completar. Este notable progreso significa que el ámbito de la computación cuántica está avanzando rápidamente y está preparado para revolucionar el panorama tecnológico en formas que apenas podemos comenzar a comprender.

El uso generalizado de dispositivos móviles y redes sociales ha aumentado enormemente las capacidades de procesamiento y acceso a información personalizada. Esto nos ha permitido convertir datos dispersos en información valiosa, lo que nos permite identificar necesidades, preferencias y hábitos de compra individuales en tiempo real. Como resultado, el marketing directo ha mejorado enormemente. En palabras de John Naisbitt, autor de Megatrends, ahora tenemos una economía que depende exclusivamente de un recurso renovable y autogenerado: la información. El desafío no radica en quedarse sin información, sino en encontrar formas de navegar a través de su abrumadora cantidad. Por lo tanto, es crucial explorar más a fondo el profundo impacto de estas tecnologías que avanzan rápidamente.

El campo del análisis empresarial utiliza una metodología conocida como Machine Learning, que es un subconjunto de la Inteligencia Artificial. Esta metodología implica analizar datos e información para comprender y describir eventos pasados, determinar las razones detrás de ellos, hacer predicciones sobre eventos futuros y proponer estrategias para lograr los resultados deseados. Al emplear técnicas de aprendizaje automático, las empresas y sus clientes pueden extraer información valiosa de las observaciones y utilizarla para tomar decisiones informadas.

El Machine Learning es un campo fascinante dentro de la inteligencia artificial que permite a las máquinas aprender y mejorar su rendimiento a través de algoritmos. Sus diversas formas de aprendizaje, como el supervisado, el no supervisado, el refuerzo y el aprendizaje profundo, permiten a las máquinas hacer predicciones, descubrir patrones y tomar decisiones informadas basadas en datos. A medida que el aprendizaje automático continúa avanzando, tiene un inmenso potencial para revolucionar numerosas industrias e impulsar la innovación en el futuro.

Así, el aprendizaje profundo consiste en una red de algoritmos que funcionan en paralelo y cada uno de los cuales contribuye al procesamiento de los datos. Como un embudo, los datos pasan por múltiples capas de algoritmos, reduciendo progresivamente la cantidad de información que se procesa. Este enfoque de múltiples capas mejora las capacidades de los sistemas de aprendizaje automático y permite un análisis y una toma de decisiones más complejos. Machine Learning (ML) es un subconjunto de la inteligencia artificial (IA) que implica el uso de algoritmos para mejorar el rendimiento de las máquinas y permitirles aprender a partir de experiencias o datos de muestra.

En términos más simples, ML permite que las máquinas aprendan sin programación explícita. Cuando estas técnicas de ML se aplican a grandes bases de datos, se denomina "minería de datos", haciendo una analogía con la extracción de materiales preciosos de las minas. Así como se obtiene una pequeña cantidad de material valioso de las minas, de la gran cantidad de datos que se analizan se extrae una pequeña cantidad de información significativa. Por otro lado, el aprendizaje no supervisado opera únicamente con datos de entrada sin ninguna variable predeterminada que predecir. Su objetivo es descubrir relaciones y similitudes dentro de los datos.

A diferencia del aprendizaje supervisado, no requiere conocimiento previo del proceso y, en cambio, se centra en agrupar puntos de datos similares e identificar patrones frecuentes como estándares de clasificación. La eficacia del aprendizaje no supervisado depende de las similitudes inherentes presentes en los datos. ML abarca varios tipos de aprendizaje, incluido el aprendizaje supervisado, el aprendizaje no supervisado, el aprendizaje por refuerzo y el aprendizaje profundo. En el aprendizaje supervisado, el algoritmo se entrena utilizando datos de entrada y salida para replicar un proceso específico. Al comprender la relación entre entradas y salidas, el algoritmo puede predecir comportamientos futuros o tomar decisiones informadas basadas en nuevos datos.

La precisión del aprendizaje supervisado depende en gran medida de la calidad y cantidad de los datos disponibles. Los problemas de regresión y clasificación se distinguen según la naturaleza del resultado. Si el resultado es un valor numérico, se considera regresión, mientras que si implica categorizar patrones, se considera un problema de clasificación. El aprendizaje por refuerzo implica un enfoque de prueba y error, donde el programa toma decisiones y recibe recompensas o castigos en función de la corrección de sus acciones. A través de intentos repetidos y retroalimentación, el programa desarrolla un algoritmo que determina la política óptima a seguir en una situación determinada.

La inteligencia artificial, es una concepción algo difícil de explicar, fue presentada por primera vez por John McCarthy en una conferencia en Dartmouth College en 1956. McCarthy la definió como la ciencia y la tecnología detrás de la creación de máquinas inteligentes. Una definición más contemporánea, proporcionada por la Comisión Europea, caracteriza la inteligencia artificial como sistemas capaces de exhibir un comportamiento inteligente analizando su entorno y tomando acciones hacia objetivos específicos, con un cierto nivel de autonomía. El propósito de la inteligencia artificial es alcanzar una inteligencia a nivel humano.

Para comprender plenamente el concepto de inteligencia a nivel humano es necesario diferenciar entre inteligencia artificial general y específica. La inteligencia específica se refiere a la capacidad de realizar una función particular, mientras que la inteligencia general abarca capacidades cognitivas generales, similares a la inteligencia humana. McCarthy enfatizó la importancia del sentido común a la hora de replicar la inteligencia humana. Estudió cómo los individuos utilizan su conocimiento y su información para determinar el mejor curso de acción. Según McCarthy, el aprendizaje y el sentido común están estrechamente entrelazados. Imaginó programas que pudieran aprender de la experiencia con tanta eficiencia como lo hacen los humanos, con el objetivo de mejorar el rendimiento de las máquinas mediante asesoramiento en lugar de reprogramación (Francés Monedero, 2020).

El enfoque de McCarthy, conocido como "el que toma consejos", implicó la construcción de un programa que pudiera razonar y deducir comportamientos apropiados. Concluyó que un programa posee sentido común si puede deducir de forma autónoma una amplia gama de consecuencias basándose en la información que se le proporciona y en el conocimiento existente. En 1960, él propuso un problema que destacaba la necesidad de que las máquinas pudieran aprender y comprender instrucciones. Sugirió que todos los aspectos del aprendizaje y la inteligencia podrían describirse con precisión para que una máquina pudiera simularlos. Sin embargo, a pesar de la existencia de inteligencia artificial específica, aún no se ha logrado una verdadera inteligencia artificial general. Esta idea fue cuestionada por A. M. Turing en 1950 cuando intentó determinar si las máquinas podían pensar. Turing concluyó que las definiciones de "pensar" y "máquina" eran insuficientes para responder la pregunta e introdujo la prueba del "juego de imitación" como alternativa.

La prueba tenía como objetivo determinar si una máquina podría comportarse como una persona pensante, sin centrarse en su apariencia física. Turing creía que una máquina pensante no tenía por qué parecerse a un ser humano. En el juego participaron tres participantes: una persona, una máquina y un interrogador, y el interrogador intentaba determinar cuál era la máquina en función de sus respuestas a un número ilimitado de preguntas. Al interrogador no se le permitió pedir demostraciones prácticas. Si el interrogador no pudiera distinguir entre la máquina y la persona, entonces podría decirse que la máquina piensa. Sin embargo, en la década de 1980, el filósofo John Searle criticó esta teoría presentando un escenario hipotético en el que la conversación era en chino y la persona que participaba no hablaba chino. Pese a ello, la persona tenía un libro que contenía la programación informática utilizada por la máquina para responder en chino. Searle argumentó que la persona podía simular el mismo programa que la máquina y mantener una conversación, aunque no entendiera el idioma. Usó este ejemplo para sugerir que pasar la prueba de Turing por sí sola no es suficiente para demostrar una verdadera inteligencia, ya que el comportamiento externo de una persona sería indistinguible del de una máquina.

El argumento conocido como la "Sala China" sugiere que aunque alguien pueda pasar la prueba de Turing respondiendo apropiadamente a las preguntas en chino, eso no significa necesariamente que comprenda el idioma. Este argumento plantea la cuestión de si memorizar un libro que contiene todas las respuestas posibles conduciría a una verdadera comprensión del chino. Sin embargo, Levesque sostiene que sería imposible crear un libro así debido a la gran cantidad de combinaciones que deberían incluirse. En cambio, sugiere que se podría crear un libro que explique el proceso de suma, permitiendo a la persona aprender y comprender cómo sumar. Según Levesque, esto haría válido el "Juego de la Imitación", y alcanzar una verdadera inteligencia artificial sería posible una vez superado el juego.

La percepción socioeconómica

A lo largo de la historia, la introducción de tecnologías innovadoras, como Internet, ha dado lugar a importantes cambios socioeconómicos, lo que ha provocado un sentimiento de aprensión entre las personas. De manera similar, cuando se trata de visualizar el futuro de la inteligencia artificial (IA), hay una notable falta de consenso a medida que surgen diversas perspectivas.

Existe un movimiento contemporáneo conocido como neoludismo que comparte similitudes con el movimiento ludita del siglo XIX, los cuales se oponen al progreso tecnológico. El ludismo original surgió en Gran Bretaña durante la revolución industrial y se caracterizó por un rechazo violento a la maquinaria debido a la preocupación por la pérdida de empleo. Sin embargo, el neoludismo adopta un enfoque más pasivo, rechazando el impacto positivo de los avances tecnológicos y considerándolos perjudiciales para la humanidad, la naturaleza y la sociedad en su conjunto. Ray Kurzweil, el inventor de los programas de reconocimiento óptico de caracteres (OCR), predice que este movimiento cobrará impulso a medida que la inteligencia artificial (IA) se integre más en la vida diaria. Además, Kurzweil sostiene que la evolución de la humanidad está estrechamente relacionada con el desarrollo de la tecnología (Kurzweil, 1999).

Así, según una exhaustiva investigación realizada por Timo Gnambs y Markus Appel en 2010, se reveló que un asombroso 72% de las personas encuestadas expresaron su temor de ser reemplazados por robots en sus respectivos trabajos. Esta estadística convincente resalta la preocupación generalizada entre la población sobre la amenaza potencial de la automatización. En este sentido, es interesante observar que sólo el 57% de los encuestados estaban abiertos a la idea de trabajar junto a un asistente robótico. Esta disparidad en las tasas de aceptación subraya aún más la compleja relación entre los humanos y la tecnología en el lugar de trabajo moderno.

Por el contrario, la Comisión Europea apoya firmemente la idea de que la inteligencia artificial (IA) no es sólo una tecnología importante de nuestro tiempo, sino más bien la más crucial y estratégica. Enfatiza que hay mucho en juego cuando se trata de IA y que nuestro enfoque hacia esta tecnología, en última instancia, dará forma al mundo en el que vivimos. De hecho, la Comisión Europea afirma que el impacto de la IA en la sociedad y en diversas industrias será tan transformador que puede compararse con el efecto revolucionario que tuvo la electricidad en numerosos sectores hace un siglo. Así como la electricidad revolucionó las industrias en aquel entonces, la IA ahora está preparada para provocar cambios profundos en las industrias a gran escala. Este sentimiento lo comparte Andrew Ng, cofundador de Coursera, quien compara la IA con la llegada de la electricidad y destaca su potencial para revolucionar y remodelar varios sectores de manera similar. Ambas perspectivas comparten el argumento común de que el impacto de la IA en nuestro mundo es inevitable, independientemente de si será ventajoso o perjudicial.

En el panorama global actual, ha habido un aumento notable en los avances tecnológicos. Esto puede atribuirse al auge de numerosas empresas de tecnología tanto en Asia como en Estados Unidos. Estas regiones han establecido la infraestructura necesaria y poseen una gran cantidad de datos, lo que contribuye al crecimiento de la industria tecnológica. Además, un examen de los cambios ocupacionales recientes en los EE. UU. revela un aumento significativo en los campos STEM, que abarcan ciencia, tecnología, ingeniería y matemáticas. Cabe señalar la aparición de diversas tecnologías nuevas, como la computación en la nube, que permite la prestación de servicios a través de Internet. Otros avances destacables incluyen el procesamiento de cantidades masivas de datos (Big Data) y la implementación de la robótica. Todas estas innovaciones desempeñan un papel fundamental a la hora de impulsar la transformación digital de las organizaciones (Banco de España, 2020).

La IA tiene el potencial de provocar la transformación tecnológica más rápida y significativa de la historia. La región de Asia y el Pacífico está liderando el camino en la adopción de la IA, y una de cada cinco empresas implementa esta tecnología. América del Norte le sigue de cerca, con una de cada diez empresas que utiliza IA. En Europa, ha habido un aumento notable en el espíritu emprendedor que rodea a las empresas relacionadas con la IA. En 2019, una de cada doce nuevas empresas centró su propuesta de valor central en la IA, en comparación con solo una de cada cincuenta empresas en 2013 (Francés Monedero, 2020).

Actualmente, Europa alberga aproximadamente 1.600 empresas de IA, con el Reino Unido a la cabeza, como el país con mayor número de estas empresas, representando un tercio del total en Europa. Francia y Alemania le siguen de cerca, mientras que España sorprendentemente ocupa la cuarta posición, superando su peso en términos de contribución. La creciente prevalencia de la IA entre los emprendedores de hoy sirve como una clara indicación de que la IA está a punto de convertirse en una fuerza omnipresente en nuestro futuro cercano (Francés Monedero, 2020).

Por lo tanto, la inteligencia artificial se ha convertido en una tendencia destacada en el mundo actual, experimentando un crecimiento rápido y sin precedentes. En consecuencia, la investigación sobre su influencia se ha convertido en un área de inmensa fascinación. En la discusión posterior, profundizaremos en el ámbito del sector financiero para explorar el impacto de la inteligencia artificial.

El sector financiero está repleto de una gran cantidad de datos, lo que allana el camino para la integración del aprendizaje automático. Sorprendentemente, la mayoría de los bancos siguen ajenos al inmenso potencial que se esconde en más del 80% de los datos que han acumulado, como revela un informe de United Consulting Group en 2018. Sin embargo, con la llegada de la digitalización y la proliferación del multicanal servicios, los datos se están volviendo cada vez más frecuentes en la industria. Esta nueva abundancia de datos presenta una oportunidad de oro para que las instituciones financieras se especialicen y se hagan un hueco ofreciendo valor añadido a sus clientes. Al aprovechar las herramientas analíticas, estas instituciones pueden anticipar con precisión las necesidades únicas de sus clientes, manteniéndose así un paso por delante en el panorama financiero en constante evolución.

Asimismo, la industria financiera ha sido reconocida como uno de los sectores líderes en el Índice de Digitalización de la Industria de MGI, lo que indica su importante adopción e inversión en inteligencia artificial. En consecuencia, no sorprende que la convergencia de las finanzas y la tecnología, conocida como Fintech, esté remodelando el panorama del sector financiero. Esta integración abarca la utilización de avances digitales y modelos de negocio inventivos habilitados por la tecnología dentro del ámbito financiero.

La inteligencia artificial, el aprendizaje automático y los Smart Data son los impulsores clave de la revolución tecnológica en este sector en particular. Entre ellas, el aprendizaje automático destaca como la disciplina de inteligencia artificial más utilizada dentro de la industria financiera (Fernández, 2019). Por lo tanto, este estudio enfatiza las aplicaciones del aprendizaje automático al tiempo que proporciona una descripción general de su proceso de implementación.

Para incorporar eficazmente el aprendizaje automático (ML) en los procesos de negocio, es crucial seguir una metodología de trabajo sistemática y desarrollar un proyecto bien definido que tenga como objetivo crear un modelo capaz de cumplir los objetivos predeterminados. Este proceso implica varias etapas, como la recopilación de datos, el preprocesamiento, la capacitación del modelo y la evaluación, que deben ejecutarse cuidadosamente para garantizar la implementación exitosa del ML en el entorno empresarial. Al adherirse a esta metodología, las empresas pueden aprovechar el poder del ML para optimizar las operaciones, mejorar la toma de decisiones, mejorar las experiencias de los clientes y, en última instancia, impulsar el crecimiento y la rentabilidad.

Para brindar una comprensión integral de las diversas etapas involucradas en el procesamiento de datos con fines comerciales, discutiremos la metodología CRISP-DM. Este modelo analítico ampliamente utilizado, conocido como Proceso Estándar Intersectorial para Minería de Datos, se originó a fines de la década de 1990 e incorpora dos elementos cruciales: una estrategia de calidad total, también conocida como mejora continua, y el concepto de tratar un proyecto como un proceso paso a paso que consta de múltiples fases. El siguiente diagrama ilustra las distintas fases de la metodología CRISP-DM.

La etapa inicial implica obtener una comprensión integral del negocio, que sirve como base para cualquier aplicación del aprendizaje automático a los datos comerciales. Esta etapa es crucial ya que nos permite evaluar la situación actual, establecer objetivos a nivel de minería de datos y desarrollar un plan de proyecto que describa claramente los resultados deseados de todo el proceso. Pasando a la segunda fase, nos centramos en los procesos de captura de datos, determinando las fuentes de las que se extraerán los datos. Esto implica buscar fuentes confiables y garantizar la calidad de los datos. Una vez identificados, decidimos un método de extracción que minimice la corrupción y cumpla con los requisitos de seguridad. Esta fase también implica la comprensión de los datos, donde realizamos tareas de exploración y gestión de calidad para identificar posibles problemas y ofrecer soluciones. A continuación, preparamos los datos estableciendo el universo de datos con el que se trabajará y realizando las tareas de limpieza necesarias. En esta fase, empleamos técnicas de preparación de datos para adaptar el conjunto de datos para su uso con varios algoritmos. La fase de modelado implica seleccionar las técnicas de aprendizaje automático más adecuadas y que produzcan los mejores resultados para nuestro conjunto de datos, teniendo en cuenta el tipo de datos y nuestros objetivos.

Adicionalmente, establecemos una estrategia para verificar la calidad del modelo. Vale la pena señalar que ningún método o algoritmo domina a los demás, ya que depende del conjunto de datos específico que se analiza. Por lo tanto, es crucial evaluar el modelo. Finalmente, diseñamos un plan de despliegue de producción de los modelos y comunicamos el conocimiento adquirido a partir de ellos dentro de nuestra organización. También llevamos a cabo una revisión integral del proyecto en su conjunto para identificar las lecciones aprendidas. Este modelo en particular evalúa sus resultados basándose en la prosperidad de la empresa en lugar de basarse en puntos de referencia estadísticos.

Aplicaciones en el sistema financiero

Las técnicas no supervisadas desempeñan un papel crucial en el análisis de grandes volúmenes de datos, particularmente en el ámbito financiero, donde se emplean para identificar posibles casos de fraude. Dado que las tarjetas de crédito se están volviendo cada vez más populares como medio de pago, la ocurrencia de actividades fraudulentas ha mostrado una tendencia a aumentar. Esto ha llevado a las instituciones financieras a recurrir a metodologías inteligentes, ya que los enfoques convencionales de detección manual de fraude demostraron ser lentos en su capacidad para mantenerse al día con la creciente tasa de fraude.

Los bancos emplean un servicio de seguridad que se activa cuando los patrones de gasto de un cliente se desvían de sus gastos habituales. Para identificar transacciones potencialmente sospechosas (conocidas como valores atípicos), se utilizan métodos no supervisados para comparar cada transacción con las anteriores. Estos métodos implican analizar diversos factores como la ubicación del cliente, sus preferencias, sus hábitos de compra y su comportamiento típico.

Los métodos supervisados se emplean en los casos en que se construye un modelo utilizando una colección de transacciones fraudulentas y legítimas para categorizar efectivamente nuevas transacciones como fraudulentas o legítimas. En un estudio realizado por Bhattacharyya, Jha, Tharakunnel y Westland (2011), se descubrió que los bosques aleatorios, un tipo de algoritmo supervisado, superaban a otros métodos en términos de diversos criterios de rendimiento. Para identificar patrones e identificar transacciones anómalas, se utilizan datos históricos y el comportamiento del cliente.

La implementación del aprendizaje automático plantea numerosos desafíos debido a diversos obstáculos, como manejar grandes cantidades de datos, navegar a través de distribuciones cambiantes y sesgadas, manejar la variabilidad de los costos de error a lo largo del tiempo (incluidos falsos positivos y falsos negativos) y adaptarse a cambios en constante evolución. comportamientos y cuestiones sociales.

Por otro lado, la utilización de la herramienta SNA también puede ayudar en la detección de fraude. El análisis de redes sociales (SNA) es una técnica que se esfuerza por identificar y comprender las conexiones entre individuos o entidades dentro de grupos sociales. Al estudiar el impacto de las interconexiones dentro de una red, el SNA pretende obtener información sobre diversos fenómenos sociales. Una red social comprende actores interconectados, que pueden ser individuos o entidades, vinculados por lazos familiares, parentesco, membresía compartida en un grupo u organización. Esta técnica se basa en la teoría de grafos y emplea mediciones matemáticas para describir la estructura de la red y el significado de la disposición de los nodos.

En este contexto, los nodos representan a los actores dentro de la red social y las relaciones entre los participantes se representan como vínculos que conectan estos nodos. En lugar de tratar a los nodos como entidades aisladas, el SNA se centra en comprender el comportamiento humano basándose en la importancia de las relaciones sociales y sus implicaciones. La importancia del estudio de las redes sociales se remonta a la antropología y la sociología, particularmente en los modelos psicométricos. Al examinar las conexiones de red a través del SNA, los modelos se vuelven menos dependientes de la subjetividad y minimizan el riesgo de perder información crítica, ya que se pueden calcular parámetros cuantitativos de la red y se pueden interpretar gráficos.

El fraude con tarjeta no presente (CNP), que se refiere a realizar pagos con una tarjeta sin necesidad de estar físicamente presente durante la transacción, está en aumento y a menudo se asocia con redes organizadas de estafadores. Para abordar este problema, el Análisis de Redes Sociales (SNA) se ha convertido en una herramienta prometedora para detectar y comprender las conexiones entre estos estafadores. A diferencia de los métodos tradicionales de detección de fraude que se basan en el análisis de puntuaciones de riesgo, SNA se centra en las relaciones entre los actores en las redes sociales para identificar comportamientos fraudulentos. Esto significa que SNA puede analizar datos de diversas fuentes, incluidas plataformas de redes sociales, registros telefónicos y pasarelas de pago, para descubrir patrones y conexiones que puedan indicar actividad fraudulenta. Al incorporar el SNA al modelo existente de detección de fraude, los investigadores esperan obtener conocimientos más profundos sobre los mecanismos subyacentes del fraude y desarrollar estrategias de prevención más efectivas.

Los métodos supervisados, como la regresión y la clasificación, desempeñan un papel crucial en la predicción de las variables de riesgo crediticio, específicamente en la calificación crediticia. Por otro lado, los métodos no supervisados se centran en el análisis y procesamiento de datos. El objetivo principal de los métodos supervisados es identificar y detectar posibles riesgos futuros que puedan resultar en incumplimiento. Vale la pena señalar que la eficacia de los algoritmos de aprendizaje automático afecta directamente la precisión de las predicciones del sistema, incluida la determinación del momento, los datos, el contenido y el canal correctos. Esta comprensión integral permite la formulación de ofertas de pago adecuadas para motivar a las personas a cumplir con sus obligaciones de deuda.

Los cuadros de mando se utilizan con el fin de evaluar el riesgo crediticio de los clientes, particularmente después de la introducción de Basilea II en 2007 por el Comité de Basilea. Este acuerdo internacional exige que las instituciones financieras posean mecanismos efectivos para evaluar el riesgo crediticio de los clientes, lo que requiere ajustes en los sistemas de presentación de informes y métodos de análisis de la información.

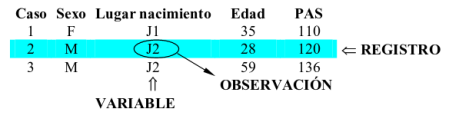

Un cuadro de mando es un modelo que utiliza datos para estimar la probabilidad de que un cliente incumpla su crédito. Esta herramienta es particularmente útil para los bancos, ya que proporciona un formato estructurado y fácil de entender para evaluar la solvencia de sus clientes. El cuadro de mando consta de varios componentes, incluidas características, atributos y puntos. Las características se refieren a los datos que se analizan sobre el cliente, como su edad y situación laboral. Los atributos, por otro lado, son las diferentes respuestas o categorías dentro de cada característica. Por ejemplo, la edad podría clasificarse en rangos como 18-25 o 25-35, mientras que la situación laboral podría clasificarse como desempleado o gerente, entre otros. Se asignan puntos a cada atributo y sirven como una puntuación que indica la probabilidad de incumplimiento del cliente. Cuantos más puntos reciba un cliente, menor será su probabilidad de incumplimiento. El número específico de puntos asignados a cada atributo está determinado por los datos históricos del banco sobre el poder predictivo de la característica y la correlación entre diferentes características .

Hay dos categorías distintas de calificación crediticia conocidas como calificación de aplicación y calificación de comportamiento. La puntuación de solicitud se centra únicamente en la información proporcionada por el cliente que busca crédito, mientras que la puntuación de comportamiento incorpora tanto la información proporcionada como los datos históricos. El proceso de creación de un cuadro de mando crediticio implica tres etapas: recopilar y construir el conjunto de datos necesario, aplicar el modelo y documentar los resultados.

El paso inicial consiste en recopilar los datos necesarios y dividirlos en dos grupos distintos. Los datos de entrenamiento, que representan el 70% del conjunto de datos, se utilizarán para construir el cuadro de mando, mientras que el 30% restante se utilizará como datos de prueba para evaluar la precisión del cuadro de mando. A continuación, debemos evaluar las características de los datos y descartar aquellos que menos contribuyen a las predicciones, simplificando el conjunto de datos. Además, es posible segmentar los datos, creando cuadros de mando separados para clientes con diferentes atributos, con el fin de mejorar las capacidades de predicción. Una vez que se ha desarrollado el modelo, se somete a pruebas utilizando los datos de prueba. Si el banco está satisfecho con la precisión del modelo a la hora de predecir resultados, se implementará para su uso.

Las instituciones financieras frecuentemente encuentran dificultades al utilizar datos históricos debido a su naturaleza desequilibrada. Este desequilibrio plantea un desafío importante para estas instituciones mientras navegan por las complejidades del análisis e interpretación de los datos. Cuando se trata de análisis de riesgo crediticio, es importante señalar que los bancos sólo tienen datos sobre los clientes a los que se les han concedido préstamos, no sobre aquellos a los que se les ha negado. En consecuencia, los datos históricos solo incluyen información sobre el número total de clientes que han recibido préstamos, no el número total de clientes que han solicitado préstamos. Los datos de las personas a quienes se les han negado préstamos no se registran, lo que genera un sesgo conocido como sesgo de rechazo.

Como resultado, los bancos tienen más casos de clientes que han pagado con éxito sus préstamos en comparación con aquellos que no lo han hecho. Equilibrar estos datos supondría un coste significativo para la empresa, ya que tendría que aprobar préstamos para personas que es poco probable que los paguen. Para abordar este problema, se pueden emplear varias técnicas de extracción de datos, como el muestreo, para mitigar el problema. La técnica más utilizada es el muestreo, que implica tres enfoques diferentes. El submuestreo implica eliminar observaciones de los datos repetidas aleatoriamente, generalmente aquellas de clientes que han pagado exitosamente sus préstamos. Por otro lado, el sobremuestreo agrega observaciones de la clase menos común, aumentando los datos existentes para esa clase en particular. Por último, se puede emplear una técnica híbrida, combinando elementos de los métodos antes mencionados para lograr un conjunto de datos equilibrado.

Un campo que está fuertemente influenciado por los algoritmos es el comercio de alta frecuencia, donde es necesario tomar decisiones en fracciones de segundo. El comercio de alta frecuencia, a menudo abreviado como HFT, es una práctica en la que los inversores emplean programas de software especializados para implementar estrategias de inversión en múltiples valores de manera sistemática y con alta frecuencia. Esta ingeniería matemática, a menudo denominada robots financieros, permite ejecutar órdenes de acciones en cuestión de segundos, lo que ha generado controversia en el mercado. Según Martínez (2010), los sistemas automáticos representan hoy más del 60% del negocio bursátil mundial, lo que genera preocupación sobre su potencial para desestabilizar el mercado. El concepto detrás de HFT era minimizar los costos de transacción y maximizar las ganancias; así el aprendizaje automático se ha convertido en una herramienta popular para ejecutar operaciones y generar alfa.

Para mejorar la eficiencia de diversas tareas, se emplea el aprendizaje por refuerzo, ya que nos permite adquirir conocimientos sobre cómo navegar y tomar decisiones de manera efectiva dentro de un entorno determinado, en lugar de predecir únicamente los resultados deseados. Al utilizar algoritmos de aprendizaje por refuerzo, podemos determinar el curso de acción más adecuado en función de las circunstancias prevalecientes. En consecuencia, esto puede proporcionar una valiosa orientación a los inversores, ayudándoles a identificar el momento y el lugar óptimos para adquirir valores financieros, minimizando así los costos y maximizando el rendimiento de la inversión.

En el ámbito de las finanzas, el término "alfa" se refiere a la capacidad de un activo financiero para superar al mercado general y lograr una mayor rentabilidad. Para lograr alfa, los analistas e inversores emplean modelos de predicción del movimiento de precios para identificar señales ventajosas que superen los costos asociados con el comercio. Este meticuloso proceso se basa en el análisis de datos pasados para determinar tendencias futuras y tomar decisiones de inversión informadas.

Para comprender el sector financiero, es fundamental tener claro lo que implica un mercado eficiente, en donde los precios de los activos financieros reflejan con precisión toda la información disponible. Esto significa que los precios de estos activos representan su verdadero valor intrínseco y se actualizan en tiempo real a medida que hay nueva información disponible. Al adherirse a esta teoría, se desacredita cualquier noción de obtener ganancias prediciendo movimientos futuros de precios. Afirma que los productos financieros no están ni infravalorados ni sobrevalorados. Según la teoría del mercado eficiente, es posible lograr altos rendimientos, pero sólo en proporción al riesgo asociado. Sin embargo, la evidencia reciente sugiere que los principios fundamentales de la teoría financiera han quedado desacreditados. El mercado financiero no es tan eficiente como se creía anteriormente, lo que permite a los inversores beneficiarse potencialmente de la predicción de futuras fluctuaciones de precios. Aquí es donde el aprendizaje automático juega un papel importante.

En los últimos años, la aplicación de algoritmos de aprendizaje automático en la predicción de precios del mercado de valores ha ganado fuerza. Wang y Wang (2017) realizaron un estudio en el que utilizaron técnicas de aprendizaje automático para desarrollar un modelo predictivo de los precios del mercado de valores. Su enfoque arrojó resultados prometedores, demostrando un alto nivel de precisión en la predicción de los precios de las acciones. Predecir los precios de las acciones o de cualquier activo financiero es una tarea compleja y desafiante.

Para investigadores Niederhoffer y Osborne (1966), los cambios en los precios suelen ocurrir en direcciones opuestas con más frecuencia que los cambios en la misma dirección. Esto pone de relieve la dificultad inherente a la predicción precisa de los movimientos de precios. Para abordar este desafío, comúnmente se emplean métodos supervisados. Estos métodos se basan en la disponibilidad de datos etiquetados, donde se conoce en todo momento el precio futuro de un activo financiero. A medida que pasa el tiempo, el conjunto de datos se actualiza constantemente con nuevos datos etiquetados, lo que permite una predicción más precisa.

En esencia, predecir precios en los mercados financieros es una tarea compleja debido a la frecuente ocurrencia de cambios en direcciones opuestas. Para superar este desafío, se utilizan métodos supervisados, aprovechando datos etiquetados para actualizar y mejorar continuamente las predicciones. Mediante el análisis cuantitativo de precios históricos y el uso de algoritmos de aprendizaje automático, los investigadores han logrado avances significativos en el desarrollo de modelos de predicción precisos de los precios del mercado de valores. El principal objetivo de estos métodos es identificar patrones y tendencias en los precios históricos de activos financieros a través de análisis cuantitativos. Al analizar los movimientos de precios pasados, los investigadores y analistas pretenden descubrir relaciones y correlaciones significativas que puedan utilizarse para predecir precios futuros.

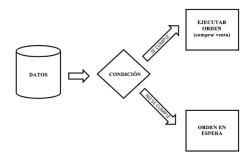

Otro uso del aprendizaje automático en el ámbito de los mercados financieros se conoce como algo-trading o comercio algorítmico. En este proceso, se programan instrucciones específicas en el software para ejecutar órdenes de compra o venta. Al incorporar algoritmos en esta práctica, los comerciantes pueden potencialmente aumentar sus ganancias minimizando los gastos comerciales, al mismo tiempo que se benefician de una mayor velocidad y frecuencia de las transacciones en comparación con las operaciones manuales. Este enfoque ayuda a aliviar la influencia de la subjetividad humana en las decisiones comerciales, haciendo que el proceso sea más metódico y sistemático.

El algoritmo requiere parámetros específicos en sus instrucciones, incluido el precio de compra o venta deseado, el volumen de instrumentos a operar y el vencimiento de la orden. Si la orden es de compra, el precio indicado representa el precio máximo que el inversor está dispuesto a pagar por el instrumento financiero. El algoritmo comprará todos los instrumentos por debajo de este precio máximo, comenzando por los de menor precio, hasta alcanzar el volumen deseado. Por el contrario, si la orden es de venta, el precio indicado es el mínimo permitido, y el algoritmo venderá a precios mayores o iguales a ese precio indicado, empezando por el más alto, hasta conseguir el volumen solicitado.

Cualquier valor que no cumpla con las condiciones de precio permanecerá en el registro de órdenes pendientes hasta que expire la orden, momento en el cual la instrucción será eliminada del sistema. Esto asegura que la máquina siga condiciones específicas para ejecutar la orden y enviarla al mercado financiero a través de la plataforma del intermediario financiero. Este enfoque garantiza la rentabilidad y ayuda a limitar las pérdidas potenciales. Para proporcionar una comprensión más clara de cómo funciona el comercio algorítmico, a continuación se incluye un gráfico visual.

Una de las aplicaciones más importantes de la inteligencia artificial en el mundo actual es el uso de chatbots, que son programas diseñados para mantener conversaciones con personas en plataformas de mensajería y esencialmente actúan como reemplazos robóticos de la interacción humana. Esta interacción puede realizarse a través de texto o audio, utilizando lenguaje natural. Los chatbots han revolucionado el servicio al cliente al permitir interacciones personalizadas entre clientes y empresas, brindando a los usuarios beneficios sociales, informativos y económicos.

Asimismo, los chatbots están disponibles las 24 horas del día, los 7 días de la semana, lo que ofrece atención al cliente continua y reduce la necesidad de que los clientes viajen físicamente a los establecimientos físicos. Además, dentro de las organizaciones se implementan chatbots para ayudar a los trabajadores a resolver cualquier duda o pregunta que puedan tener. En el sector financiero, los chatbots tienen un inmenso potencial y pueden servir como asistentes de recursos humanos, asistentes de inteligencia de mercado, asistentes de flujo de trabajo, asistentes de redes sociales, asistentes de analistas financieros, asistentes de programación e incluso como embajadores de la empresa Es de destacar que sólo el 20% del trabajo administrativo representa un asombroso 85% del costo total para los bancos. Para 2022, se estima que los chatbots generarán más de 8 mil millones de dólares en ahorros de costos anuales (United Consulting Group, 2018).

Los chatbots representan alrededor del 9,6% del suministro total de productos de IA. Sin embargo, en la industria bancaria, se utilizan en aproximadamente el 33,9% de los casos de uso de IA (Francés Monedero, 2020). Esta importante dependencia de los chatbots por parte de los bancos puede deberse a su deseo de presentarse como innovadores y tecnológicamente avanzados. Desafortunadamente, muchos bancos carecen de una estrategia clara de IA. Ian Wilson, ex director de IA de HSBC, señaló que la pregunta más común en los bancos es sobre el futuro y el retorno de la inversión, pero no hay una respuesta satisfactoria para esto, lo que plantea un problema. Además, estos programas de chatbot tienen una capacidad limitada para manejar consultas básicas de los clientes.

Debido a que el lenguaje humano es complejo, plantea un desafío para los chatbots entablar conversaciones fluidas y coherentes. Sin embargo, el programa informático Eugene logró un hito importante en 2014 al superar con éxito la prueba de Turing. Este avance marcó un importante punto de inflexión, ya que permitió a las máquinas utilizar técnicas de aprendizaje automático para entablar un diálogo significativo con los humanos.

Inicialmente, el desarrollo de chatbots se basó en la experiencia de profesionales y siguió estándares establecidos. Si bien, a medida que pasó el tiempo, se introdujeron proyectos híbridos que combinaban técnicas de aprendizaje automático con enfoques tradicionales. Actualmente, hay un cambio hacia chatbots que utilizan únicamente el aprendizaje automático. Estos sistemas avanzados de chatbot se entrenan continuamente utilizando datos históricos, lo que les permite mejorar indefinidamente a medida que acumulan más información.

El algoritmo empleado por estos chatbots está diseñado para identificar la intención del usuario y extraer información relevante de sus mensajes. Al evaluar el problema del cliente, el sistema puede generar una respuesta adecuada. Esto se logra analizando las soluciones más comunes que se encuentran en el conjunto de datos y devolviéndolas al sistema mediante el aprendizaje supervisado. En los casos en los que hay múltiples respuestas potenciales, el chatbot emplea técnicas de aprendizaje profundo para evaluar el contexto de la conversación y selecciona la respuesta más adecuada en función de la entrada actual.

El funcionamiento de los chatbots implica la utilización de diversas técnicas. Para facilitar la interacción con los usuarios, la interfaz del software se basa en la aplicación de Procesamiento del Lenguaje Natural (NLP). La NLP, al ser una subdivisión de la inteligencia artificial, abarca la capacidad de las máquinas para comprender el lenguaje humano. Este campo se centra en procesar la información recibida de una manera que permita a las máquinas interpretarla de forma eficaz. Por otro lado, el backend, específicamente el procesador de entrada frontend, utiliza técnicas de aprendizaje supervisado y aprendizaje profundo para mejorar su funcionalidad.

España ha ostentado el título de ser el país más bancarizado del mundo, con un impresionante número de sucursales por persona, con la asombrosa cifra de 95,87 sucursales por cada 100.000 personas (Camino y de Garcillán López-Rua, 2014). Sin embargo, esta distinción está experimentando gradualmente una transformación, todo gracias a la llegada de tecnologías innovadoras. Una famosa cita de Bill Gates de 1994 destaca este cambio de perspectiva: "Necesitamos el sistema financiero, pero no los bancos". La aparición de aplicaciones móviles y servicios automatizados en línea está revolucionando el panorama financiero, ofreciendo una experiencia altamente personalizada y adaptada a los clientes. Estas innovadoras plataformas financieras, acertadamente denominadas "roboadvisors", están allanando el camino hacia una nueva era de la banca.

Esta herramienta utiliza algoritmos de aprendizaje automático para ofrecer asesoramiento de inversión a los clientes. Al interactuar con el cliente y analizar sus ingresos y gastos pasados, la máquina puede sugerir planes de ahorro e inversión. El cliente crea un perfil y responde una serie de preguntas, lo que permite que el programa informático comprenda su perfil de riesgo, preferencias de activos y más. Utilizando esta información, el robo-advisor aplica algoritmos para brindar una recomendación personalizada. La integración de los robo-advisors en el ciclo financiero bancario permite una mejor planificación financiera que se alinea con el ciclo de vida y el perfil de riesgo del cliente, ayudándole a alcanzar sus objetivos financieros.

Al implementar este enfoque, la utilización de dicha tecnología tiene el potencial de disminuir significativamente la cantidad de oficinas operativas necesarias para atender a los clientes. Además, los robo-advisors ofrecen una oportunidad invaluable para que una parte sustancial de la población, que tal vez no posea conocimientos financieros fundamentales, participe en inversiones, ahorros e incluso planificación de la jubilación.

El campo del análisis y reconocimiento de documentos (DAR) se centra en la extracción automatizada de información de los documentos, con el objetivo de identificar las cuestiones clave que deben abordarse para la evaluación, resaltando así la información más significativa. Según Marinai y Fujisawa (2007), la integración de técnicas de aprendizaje automático (ML) en este proceso de análisis es muy ventajosa. El proceso de análisis de documentos consta de tres fases principales: recopilación y almacenamiento de información, preprocesamiento de datos y aplicación de diversas técnicas de análisis. La fase de procesamiento de la información es crucial porque los documentos normalmente contienen datos no estructurados y carecen de una organización definida. Para abordar esto, se emplean técnicas de simplificación, como reducir las palabras a sus raíces o eliminar palabras irrelevantes que no contribuyen al significado general de las oraciones. Luego, en la fase de análisis se aplican diferentes técnicas para escudriñar el texto. Esto puede implicar un análisis cuantitativo, en el que se examina la repetición de ciertas palabras dentro del mismo documento para medir la importancia del tema en el texto presentado, o puede abarcar un análisis de sentimientos, entre otros métodos.

Esta herramienta cambia las reglas del juego en el sector financiero, ya que permite escanear y extraer información crucial de documentos extensos, brindando inmensos beneficios a través de la implementación de tecnología de aprendizaje automático. Al utilizar la plataforma COiN, JP Morgan ha revolucionado sus operaciones al recuperar sin esfuerzo datos vitales de acuerdos de crédito comerciales anuales en cuestión de segundos. Esto ha dado como resultado un asombroso ahorro de tiempo de 360.000 horas al año, que de otro modo se gastarían en tediosas revisiones manuales. La utilización de esta herramienta muestra el increíble potencial del aprendizaje automático para abordar de manera eficiente las necesidades de la industria financiera.

Las ventajas ML en el sistema financiero

En el pasado, las instituciones financieras utilizaban el precio, la velocidad y el acceso para atraer clientes. Si bien, con la llegada de la globalización, este enfoque ha cambiado. Ahora, la capacidad de analizar grandes cantidades de datos y utilizar algoritmos para identificar los productos que mejor satisfacen las necesidades de los clientes es crucial para obtener una ventaja competitiva. Las expectativas de los clientes también han evolucionado, con una demanda creciente de ofertas diversas y personalizadas. Como resultado, la estandarización ya no es una fuente importante de ingresos. En cambio, la atención se centra en ofrecer productos altamente personalizados, donde la inteligencia artificial (IA) juega un papel crucial. Este cambio en la industria ha llevado a que los grandes operadores tradicionales se conviertan en proveedores de servicios de IA.

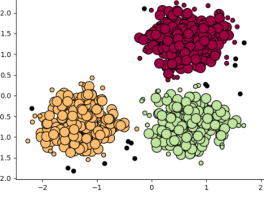

El aprendizaje automático permite la segmentación de clientes, facilitando así el desarrollo de estrategias personalizadas basadas en sus características únicas. Es importante que los individuos dentro del mismo segmento posean similitudes entre ellos pero también muestren diferencias en comparación con otros grupos. Al implementar diversas estrategias para varios segmentos, las empresas pueden ofrecer experiencias más personalizadas a sus clientes.

Como resultado, la implementación de tecnología de aprendizaje automático otorgará una importante ventaja competitiva a las instituciones financieras que la adopten, permitiéndoles ofrecer niveles incomparables de servicio al cliente personalizado. Esta tecnología de vanguardia permite a estas entidades adaptar sus servicios a las preferencias y necesidades individuales, estableciendo así una conexión más fuerte con su clientela. Al aprovechar los algoritmos de aprendizaje automático, las empresas del sector financiero pueden obtener información valiosa sobre el comportamiento de los clientes, anticipar sus requisitos únicos y ofrecer soluciones personalizadas de forma proactiva. Con la capacidad de analizar grandes cantidades de datos de manera eficiente y precisa, el aprendizaje automático equipa a estas entidades con las herramientas para mejorar la satisfacción y lealtad del cliente. En consecuencia, las organizaciones que adopten el aprendizaje automático en la industria financiera no solo prosperarán en un mercado altamente competitivo, sino que también revolucionarán la forma en que interactúan y atienden a sus clientes.

Las instituciones financieras pueden automatizar tareas repetitivas o tareas que aportan menos valor mediante técnicas como el procesamiento del lenguaje natural o el reconocimiento de imágenes. Por ejemplo, las preguntas más frecuentes se pueden responder utilizando estas técnicas. Amazon ha implementado más de cien mil robots en todo el mundo. Según el director de operaciones, Dave Clark, el objetivo era que las máquinas realizaran tareas monótonas, permitiendo a los humanos realizar trabajos mentalmente interesantes. En lugar de humanos versus máquinas, la IA se trata de humanos mejorados por máquinas, como afirman Jubraj, Graham y Ryan. La IA tiene el potencial de mejorar las habilidades humanas y optimizar el tiempo de los empleados de la empresa liberándolos de tareas repetitivas y permitiéndoles centrarse en tareas más valiosas.

A lo largo de la historia, los economistas han sostenido la creencia de que las máquinas poseen el potencial de reemplazar a múltiples trabajadores humanos en diversas industrias. Sin embargo, su argumento final ha sido que tales avances tecnológicos conducirían a un aumento significativo en los niveles de productividad, lo que en consecuencia resultaría en un aumento sustancial tanto del ingreso como del producto interno.

Como resultado, la cadena de valor sufrirá una transformación significativa en términos de generación de beneficios. Con el tiempo, habrá un cambio notable en la distribución del valor hacia tareas que exigen experiencia especializada, mientras que los servicios que pueden ejecutarse sin la participación de profesionales experimentados serán menos valorados por la sociedad. La razón detrás de este cambio de percepción radica en la llegada del aprendizaje automático, que permite realizar estas tareas a un costo considerablemente reducido.

Dentro de la industria financiera, si se automatizaran las tareas más monótonas, se liberaría una cantidad significativa de tiempo para los equipos de gestión financiera. Según Chui, Manyika y Miremadi (2015), esto podría representar potencialmente más del 20% de su carga de trabajo total. Al delegar responsabilidades como la recopilación, verificación y consolidación de datos a las máquinas, los profesionales de este campo tendrían la oportunidad de concentrar sus esfuerzos en aspectos más cruciales como el análisis y la toma de decisiones. El nivel de automatización de tareas sería directamente proporcional a la medida en que el trabajo de un empleado comprenda actividades rutinarias.

Cuando se trata de trabajadores responsables de aprobar préstamos hipotecarios, el aprendizaje automático se hará cargo de la tarea repetitiva de recopilar y analizar datos. Esto permitirá a los empleados gestionar un mayor número de solicitudes de préstamos y brindar asesoramiento a un mayor número de clientes. Como resultado, los empleados podrán hacer un uso más eficiente de su tiempo aprovechando el análisis de datos realizado por las máquinas.

Por el contrario, los asesores financieros darán prioridad a comprender las necesidades de sus clientes y formular diversas tácticas para lograr sus objetivos, dedicando comparativamente menos tiempo a examinar el estado financiero de los clientes. Las máquinas agilizarán el procesamiento y evaluación de los datos de cada cliente, tarea que antes realizaban empleados humanos del sector.

En un estudio realizado por McKinsey en 2018, se descubrió que a pesar de la automatización de las tareas manuales, la creación de nuevos puestos de trabajo superará el número de puestos de trabajo reemplazados. El estudio sugiere que los beneficios de la inteligencia artificial irán más allá de la simple sustitución de puestos de trabajo, ya que solo una fracción de los beneficios totales procederá de la sustitución de puestos de trabajo (Francés Monedero, 2020).

Así en la medida que las empresas adopten la IA, habrá un cambio en las habilidades necesarias para los puestos de trabajo. La demanda de habilidades físicas disminuirá, lo que resultará en un exceso de oferta, mientras que la demanda de habilidades cognitivas aumentará. En consecuencia, habrá un aumento de los salarios. El auge de las máquinas en el sector bancario, según informa Bloomberg, redefinirá los roles y funciones de los empleados bancarios. Esto ha generado una gran demanda de candidatos con experiencia en inteligencia artificial, aprendizaje automático y ciencia de datos en el sector financiero, según portales de empleo como Glassdoor y Linkedin (Francés Monedero, 2020).

De similar forma, a medida que ciertas tareas en el sector financiero se automaticen, habrá una mayor necesidad de puestos centrados en la gestión de relaciones con los clientes (CRM) para brindar un servicio más personalizado a los clientes. Si bien las máquinas pueden generar recomendaciones, son los empleados humanos quienes mejoran la experiencia del cliente a través de interacciones personalizadas. Por tanto, la cooperación entre la inteligencia emocional humana y la eficiencia de las máquinas es crucial en esta industria.

En actividades que requieren toma de decisiones, la objetividad es crucial. El aprendizaje automático ofrece un mayor nivel de precisión, ya que puede analizar datos de diversas fuentes, en diferentes formatos, y verificar su valide. Esto reduce la influencia de la subjetividad de un individuo en la toma de decisiones. Un ejemplo de la importancia de la objetividad en las actividades empresariales es la auditoría. Cuando las empresas alcanzan un determinado nivel de capital, están obligadas por ley (en España, por ejemplo) a someterse a auditorías externas realizadas por auditores independientes. Estos auditores no deben tener ninguna asociación con las operaciones de la empresa. Esto garantiza la confiabilidad de los estados financieros y elimina los conflictos de intereses.

Esta objetividad es particularmente valiosa en sectores como el financiero, donde la toma de decisiones implica elegir entre múltiples opciones que impactan directamente el bienestar financiero de los clientes. En tales casos, es necesario disponer de información completa y seleccionar estrategias con la máxima objetividad. Los asesores humanos, por otro lado, son subjetivos, propensos a errores y consumen mucho tiempo. Por el contrario, los algoritmos son objetivos, más precisos, más rápidos, eficientes y pueden funcionar 24 horas al día, 7 días a la semana.

El aprendizaje automático procesa datos con precisión. Por ejemplo, cuando se realiza un análisis cualitativo de la probabilidad de incumplimiento crediticio, la información de entrada utilizada para evaluar el riesgo crediticio de un cliente es a menudo subjetiva y vaga. Abordar esta cuestión es crucial para garantizar una mayor objetividad y cumplimiento de las directrices establecidas por el Banco de Pagos Internacionales (BPI). El BPI es responsable de mantener la estabilidad del sistema financiero y monetario internacional. En 2015, el BPI publicó once principios de orientación supervisora sobre el riesgo crediticio y la contabilización de las pérdidas crediticias esperadas. El principio número dos enfatiza la importancia de que los bancos adopten y se adhieran a metodologías sólidas para evaluar y calcular el riesgo crediticio en todas las exposiciones crediticias (Banco de Pagos Internacionales, 2015).

Tradicionalmente, los bancos recopilaban información de los solicitantes de préstamos a través de formularios de solicitud y otras fuentes para evaluar si el préstamo debía otorgarse y sus términos. Luego, los empleados analizarían esta información y tomarían una decisión. Sin embargo, no era raro que diferentes asesores llegaran a conclusiones diferentes sobre si se debía conceder o no un préstamo. Al utilizar el aprendizaje automático, se puede crear un modelo de calificación crediticia estandarizado, garantizando que la decisión sea universal y no dependa del análisis de un individuo.

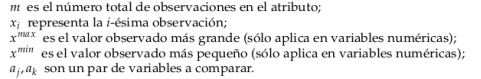

Los datos del aprendizaje automático se caracterizan por tres factores principales: volumen, variedad y velocidad.

- El volumen de datos ha aumentado significativamente debido a la amplia cobertura y conexiones de Internet, lo que plantea el desafío de almacenar cantidades tan grandes de información.

- La variedad de fuentes de medios, diversas representaciones y disponibilidad de datos hacen que su análisis sea una tarea compleja.

- Además, la velocidad a la que se generan los datos ha aumentado exponencialmente con el avance de la difusión de datos desde diversos dispositivos. Es fundamental analizar y almacenar estos datos de manera eficiente y rápida para evitar incurrir en costos de oportunidad, ya que puede no siempre ser factible analizar cada pieza de información.

El concepto de Internet de las Cosas, comúnmente conocido como IoT, abarca la conectividad y comunicación entre varios objetos y dispositivos a través de una red privada o basada en Internet. Esta interconexión permite una interacción perfecta y el intercambio continuo de datos entre estos dispositivos conectados. En consecuencia, el gran volumen de datos que se transmiten, que incluye información tanto cuantitativa como cualitativa, es notablemente vasto.

Los dispositivos móviles han contribuido significativamente a la expansión de las operaciones y la acumulación de una gran cantidad de datos en el sector financiero. Para aprovechar y extraer eficazmente información valiosa de esta abundancia de datos, la integración de algoritmos de aprendizaje automático se ha vuelto esencial. Estos algoritmos permiten el procesamiento de datos en tiempo real, facilitando así la recuperación inmediata de información valiosa. Esta innovadora incorporación de la inteligencia artificial en el sector financiero ha revolucionado los procesos, particularmente mediante la implementación de sistemas automáticos de reconocimiento de dígitos.

Así se tiene que, los mercados financieros funcionan las 24 horas del día y la capacidad de procesar datos comerciales rápidamente es crucial para una gestión comercial eficaz. Como resultado, la tecnología de aprendizaje automático permite a las personas tomar decisiones en tiempo real, lo que les permite posicionarse estratégicamente y prever resultados potenciales en los dinámicos mercados financieros.

En la misma línea, los cambios mencionados, que se caracterizan por su rapidez y amplitud, tienen un profundo impacto en las operaciones y funciones del Banco de España. Estos cambios no solo influyen en los procesos internos del banco sino que también tienen implicaciones significativas para sus funciones analíticas y de supervisión (Banco de España, 2020). El sector financiero se enfrenta constantemente a regulaciones y estándares de presentación de informes novedosos, lo que requiere la capacidad de adaptarse rápidamente a estos requisitos en evolución.

El aprendizaje automático no sólo acelera el procesamiento de los datos y la información de un cliente, sino que también acelera la capacitación de los empleados bancarios, lo que resulta en una mayor productividad y rentabilidad para las organizaciones. Al automatizar las tareas, se reduce el tiempo necesario para su ejecución, acelerando así la curva de aprendizaje de los nuevos empleados. Además, la utilización del aprendizaje automático infunde confianza en el trabajo de estos nuevos empleados, ya que están respaldados por la confiabilidad de los algoritmos.

En la actualidad, existe una disparidad en la accesibilidad a los servicios sanitarios y financieros, y solo determinadas clases sociales tienen fácil acceso a ellos. Sin embargo, la utilización del aprendizaje automático puede revolucionar la eficiencia de estos servicios y permitirles llegar a una gama más amplia de personas. Esto es particularmente significativo cuando se consideran préstamos pequeños, como los requeridos por las pequeñas empresas, donde el monto relativamente bajo del préstamo y el riesgo potencial involucrado para los prestamistas no justifican los gastos asociados con la evaluación de la solvencia del prestatario. En tales casos, la integración de técnicas de aprendizaje automático ofrece una solución óptima, que permite que una mayor parte de la población aproveche los servicios financieros.

Por el contrario, en los casos en que una parte de las tareas esté automatizada, las comisiones que reciben los asesores financieros se reducirían, lo que aumentaría el atractivo para una clientela más amplia. Además, si bien adoptar el aprendizaje automático (ML) tiene ventajas innegables, es importante reconocer la existencia de ciertos obstáculos y complejidades que presenta.

Los desafíos de la ML

La incorporación de la inteligencia artificial (IA) en las empresas ha creado la necesidad de contratar científicos de datos que posean la experiencia necesaria. Aun cuando, debido a la intensa competencia, encontrar personal con las habilidades adecuadas se ha convertido en una tarea desafiante. Actualmente, existe una mayor demanda de estas personas calificadas que la oferta disponible. Como resultado, las empresas que deseen implementar el aprendizaje automático en sus servicios deben hacer todo lo posible no sólo para atraer, sino también para retener a estos especialistas.

Vale la pena señalar que el 90% de las 1.600 startups de IA en Europa se centran principalmente en ofrecer servicios de IA a otras empresas. Esto indica que determinadas empresas optan por subcontratar sus servicios de aprendizaje automático a proveedores externos. Para las empresas en esta situación, los factores claves del éxito residen en integrar eficazmente estos servicios externalizados y establecer una relación de largo plazo con sus proveedores. Dado el número limitado de profesionales en este campo, si las empresas del sector financiero dependieran en gran medida del aprendizaje automático para sus operaciones, podría aumentar su riesgo operativo e incluso generar un riesgo sistémico.

Un factor crucial para la implementación exitosa de la IA es la posesión de amplios conjuntos de datos para el desarrollo de algoritmos, y garantizar el acceso a estos datos es esencial. Además, la cantidad de esfuerzo humano necesaria para recopilar estos datos es inmensa, ya que antes implicaba una cantidad significativa de tiempo para la extracción, pero ahora se centra más en la preparación. Esto es particularmente importante debido a las características específicas de los datos utilizados en el aprendizaje automático, como el volumen, la variedad y la velocidad, que requieren un proceso de captura de datos eficiente. Sin embargo, el sector financiero no enfrenta este desafío porque ya posee una vasta base de datos acumulada con el tiempo debido al sistema contable y los requisitos regulatorios. Estos registros históricos, que inicialmente no fueron plenamente reconocidos por su potencial, ahora tienen un valor significativo. También, el sector financiero ha evolucionado hacia una industria multicanal, lo que se ha traducido en un mayor volumen de datos generados desde diversos dispositivos en un período de tiempo más corto a través de transacciones monetarias. Como resultado, el sector financiero se enfrenta ahora a una cantidad tan enorme de datos que se ha hecho necesario emplear técnicas para analizarlos.

Por el contrario, el aprendizaje automático tiene el potencial de incorporar sesgos de datos históricos, incluidos los relacionados con el género y la raza. Como resultado, cuando se trata de brindar servicios financieros a grupos minoritarios, estos algoritmos pueden no ser los más adecuados. La precisión a la hora de clasificar personas con diferentes tonos de piel, ya sean hombres o mujeres, varía significativamente debido a la presencia predominante de personas de piel clara en los conjuntos de datos. En esencia, los propios algoritmos de aprendizaje automático pueden ser imparciales, pero no se puede ignorar la naturaleza sesgada de los datos con los que se entrenan. Para garantizar la equidad y la transparencia en la toma de decisiones algorítmicas para las instituciones financieras, es crucial adoptar conjuntos de datos diversos e inclusivos, así como emplear los métodos de capacitación y enfoques de desarrollo de algoritmos más efectivos.

Un ejemplo lo constituye Amazon, que intentó desarrollar un algoritmo de aprendizaje automático con el objetivo de acelerar su proceso de selección de personal. El objetivo principal era examinar los CV de las personas y excluir a aquellos que, según los datos históricos de la empresa, era poco probable que fueran contratados. El algoritmo utilizó todos los CV de la década anterior, sin tener en cuenta el género. Sin embargo, surgió un problema notable cuando se descubrió que el modelo frecuentemente ignoraba a las mujeres como candidatas potenciales debido a sesgos inherentes en el conjunto de datos, que favorecían la contratación de hombres. Tras un examen más detenido, se descubrió que el algoritmo pasaba por alto los CV que contenían los términos "mujer" o "femenino" durante el proceso de selección. Otro ejemplo que destaca las deficiencias de los sistemas algorítmicos es la implementación por parte de Google de un algoritmo de reconocimiento facial que identificó incorrectamente a los individuos negros como gorilas. Este etiquetado erróneo fue consecuencia de observaciones insuficientes de caras negras en el conjunto de datos utilizado para entrenar el modelo.

El uso de algoritmos en el sector financiero, particularmente en actividades como ofrecer crédito o negociar activos financieros, tiene el potencial de dar lugar a casos de agregación y, con el tiempo, podría conducir a un comportamiento procíclico.

La competencia

Se espera que el surgimiento de la economía de la IA cree un panorama competitivo que favorezca a las instituciones establecidas con importantes cuotas de mercado e innovadores ágiles. En consecuencia, existe la preocupación de que esto pueda conducir a una situación monopolística en la que las grandes instituciones financieras tradicionales dominen el mercado, ya que las pequeñas y medianas empresas pueden carecer de la inversión necesaria para mantenerse al día con los avances tecnológicos. Esta preocupación está respaldada por un estudio realizado por Edelman y el Foro Económico Mundial en 2019, que encontró que el 54% del público en general y el 43% de los líderes tecnológicos creen que la IA tendrá implicaciones negativas para las personas más vulnerables, mientras que el 67% y El 75% respectivamente prevé que beneficiará principalmente a los más ricos. Estos hallazgos resaltan la posibilidad de que surjan desequilibrios como resultado de la economía de la IA (Francés Monedero, 2020).

La brecha entre las empresas que optan por implementar el aprendizaje automático y las que no seguirán creciendo a medida que las primeras inviertan más en tecnología de aprendizaje automático y recopilen más datos. Es fundamental que las empresas se anticipen a este cambio e incorporen el aprendizaje automático en sus operaciones. De no hacerlo, estas empresas podrían verse expulsadas del mercado debido a la intensa competencia. En consecuencia, habrá un cambio en el panorama competitivo, lo que requerirá nuevos factores para lograr el éxito. El aprendizaje automático acelerará enormemente los procesos comerciales, lo que conducirá a ciclos más rápidos de innovación, adopción y consumo. Esta aceleración ha reducido históricamente el tiempo que las grandes empresas siguen siendo líderes del mercado. Es probable que el aprendizaje automático proporcione una ventaja competitiva, creando potencialmente un monopolio para las grandes empresas, dejando solo a un pequeño grupo de competidores.

El accionar

Las empresas enfrentan dificultades al intentar aplicar algoritmos que fueron desarrollados para situaciones específicas a otros casos similares pero diferentes. Este problema surge porque el uso de algoritmos en datos con los que no fueron entrenados originalmente puede crear problemas. Para superar este desafío, es necesario desarrollar algoritmos que puedan aplicarse en un contexto más amplio. Esto se puede lograr incorporando datos heterogéneos, que consisten en observaciones de varios escenarios.

En 2012, Knight Capital, una empresa especializada en negociación de acciones, desarrolló un programa de software diseñado específicamente para negociar valores de acciones en la Bolsa de Nueva York. Sin embargo, se produjo un desafortunado fallo informático que provocó que la empresa sufriera una asombrosa pérdida de 440 millones de dólares en tan solo 45 minutos. Afortunadamente, la empresa reconoció rápidamente el problema y detuvo rápidamente el funcionamiento del algoritmo. El algoritmo participaba constantemente en la compra y venta de millones de acciones, lo que provocó un aumento significativo de la demanda y, posteriormente, elevó los precios de las acciones. En consecuencia, las acciones se sobrevaluaron, lo que resultó en pérdidas financieras sustanciales para la empresa (Harford, 2012). Aunque el algoritmo había sido programado para identificar y comprar acciones infravaloradas, no tuvo en cuenta el hecho de que comprar una gran cantidad de acciones crearía un aumento en la demanda, inflando así sus precios y anulando su estado infravalorado inicial.

Legislación y ética

La ciberseguridad es fundamental para el funcionamiento de la economía digital y tiene como objetivo salvaguardar a los usuarios, activos y recursos digitales (como redes, equipos y contenidos) del uso no autorizado en el entorno cibernético. Toda comunicación involucra un remitente, un receptor y un mensaje transmitido. Hay cuatro propiedades que garantizan la confianza o seguridad digital:

- autenticidad (verificar que el mensaje recibido fue enviado por el remitente previsto),

- integridad (garantizar que el mensaje recibido no ha sido alterado),

- confidencialidad (garantizar que el mensaje sólo puede ser leído por destinatario previsto), y

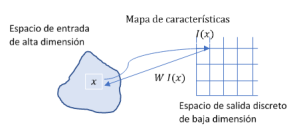

- el no repudio (evitar que el remitente niegue su autoría del mensaje).