Modelos probabilísticos y determinísticos para toma de decisiones y administración de empresas

Modelos probabilísticos y determinísticos para toma de decisiones y administración de empresas

Oscar Antonio Robles Villanueva, Mariel Del Rocío Chotón Calvo, María Silvia Villa Santillan, Ricardo Antonio Armas Juarez, Mariela Lizety Cordova Espinoza, Ricardo Martin Gomez Arce

© Oscar Antonio Robles Villanueva, Mariel Del Rocío Chotón Calvo, María Silvia Villa Santillan, Ricardo Antonio Armas Juarez, Mariela Lizety Cordova Espinoza, Ricardo Martin Gomez Arce, 2024

Primera edición: Julio, 2024

Editado por:

Editorial Mar Caribe

Av. General Flores 547, Colonia, Colonia-Uruguay.

RUC: 15605646601

Diseño de cubierta: Yelitza Sánchez Cáceres

Libro electrónico disponible en https://editorialmarcaribe.es/modelos-probabilisticos-y-deterministicos-para-toma-de-decisiones-y-administracion-de-empresas/

Formato: electrónico

ISBN: 978-9915-9682-4-7

Aviso de derechos de atribución no comercial: Los autores pueden autorizar al público en general a reutilizar sus obras únicamente con fines no lucrativos, los lectores pueden usar una obra para generar otra obra, siempre y cuando se dé el crédito de investigación y, otorgan a la editorial el derecho de publicar primero su ensayo bajo los términos de la licencia CC BY-NC 4.0.

ÍNDICE

1. LA INVESTIGACIÓN DE OPERACIONES.

![]() 1.1 Modelos de la Investigación de Operaciones.

1.1 Modelos de la Investigación de Operaciones.

La necesidad de una escala numérica y mesurable.

Clasificación de las características.

1.2 La Modelización en la toma de Decisiones.

1.4 Algunas diferencias entre el Diseño y la Materialización del Modelo.

1.5 Elementos Estructurado para la toma de Decisiones.

Estructuración del Proceso de Toma de Decisiones.

1.6 Las limitaciones de la Naturaleza Humana.

1.7 Diagramas Causales o de Lazos.

1.8 Modelo Migración Población, Migración, Empleo.

1.9 Relaciones Causa-Efecto Modelos de Aplicación.

Población Empleada Positivo. Lazo Migración

1.10 Modelo de la Oferta con retardo.

EL PROCESO DE TOMA DE DECISIONES ANTE SITUACIONES QUE IMPLICAN RIESGO E INCERTIDUMBRE.

Exactitud del Modelo Estadístico.

2.1. De los datos a un conocimiento decisivo.

2.2 Toma de Decisiones Estadística.

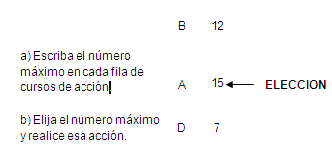

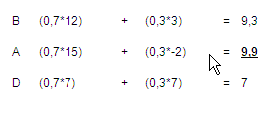

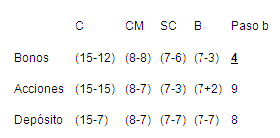

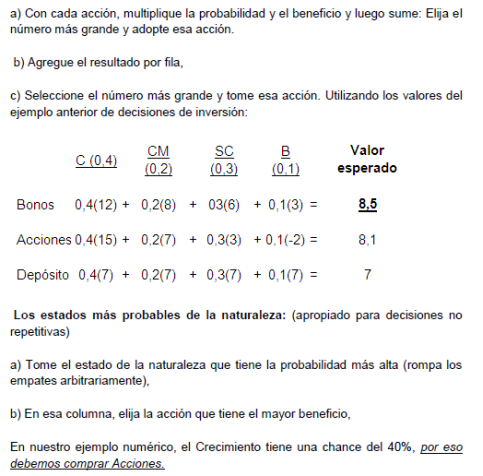

Estrategias para la toma de Decisiones.

2.3 Proceso de Toma de Decisiones.

2.4 Modelos de Decisión Estocásticos.

Elementos de un Modelo Probabilístico.

La Relevancia de la Información disminuye la Incertidumbre.

2.6 Tomar Decisiones en la Incertidumbre

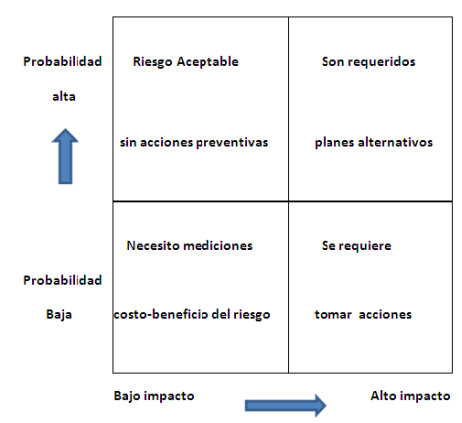

2.7 Consideración de los Riesgos.

2.8 Respuestas con respecto al riesgo y su impacto.

2.9 Cuando se Evalúa el Riesgo,

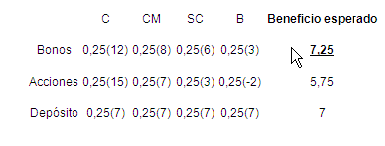

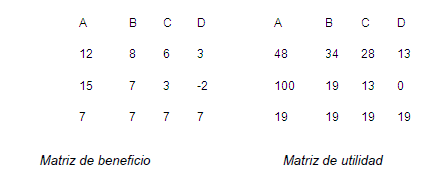

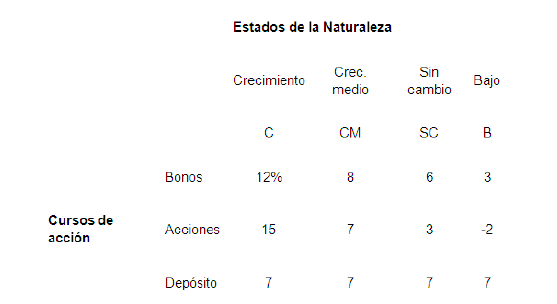

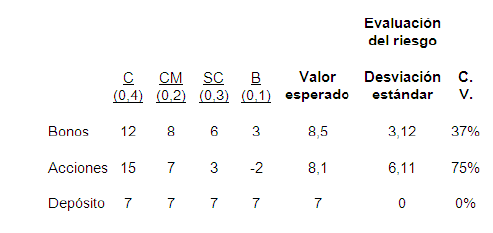

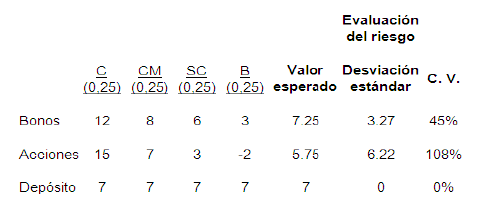

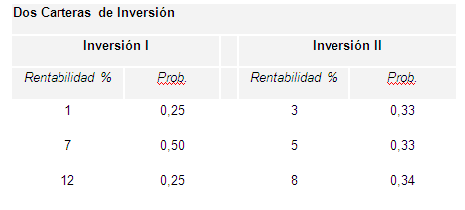

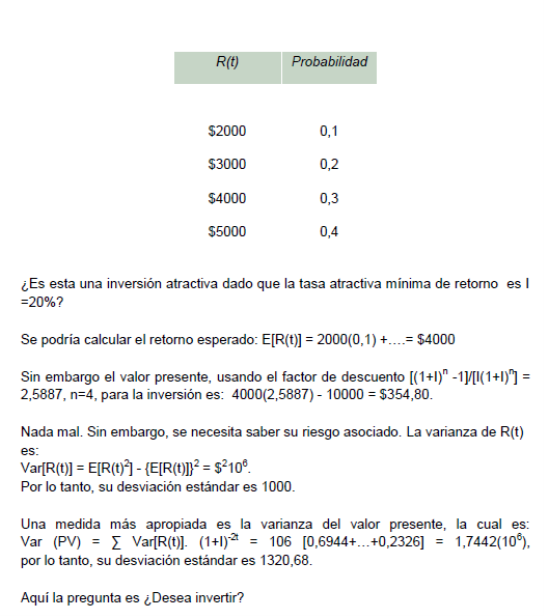

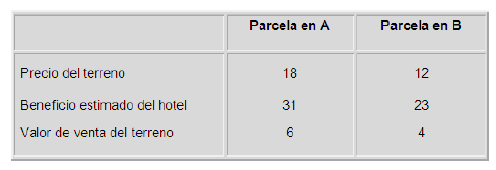

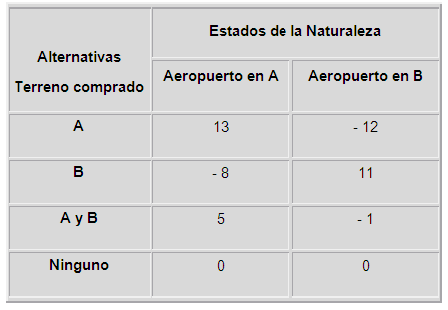

2.10 Análisis de Dos Inversiones.

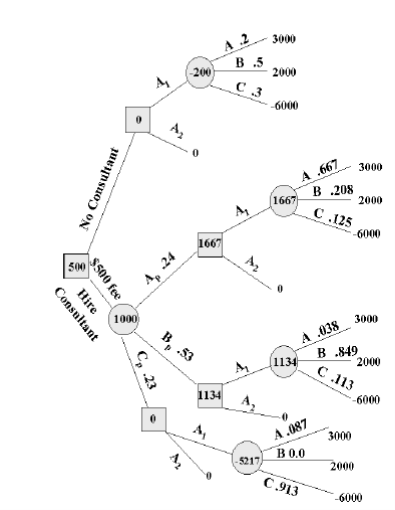

2.11 El Árbol de Decisiones y la Matriz.

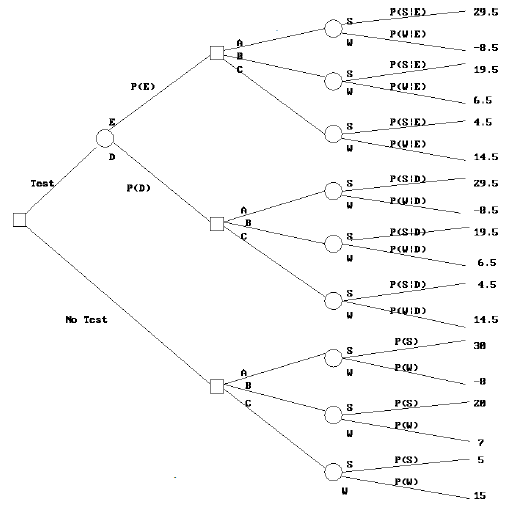

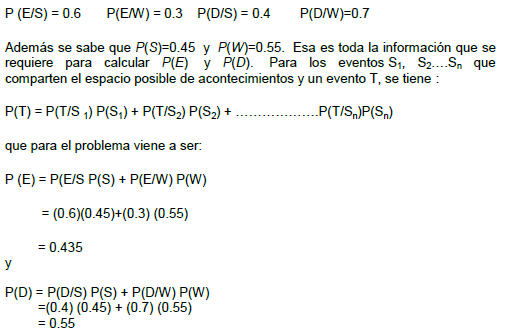

Árbol de decisión reducido para ABC

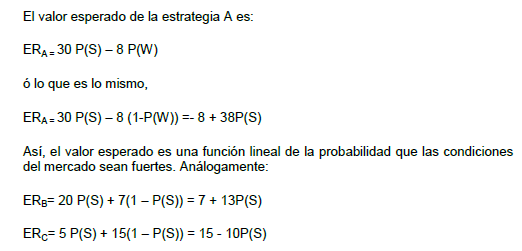

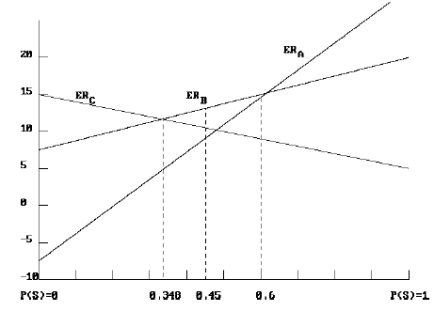

Valor esperado en función de P(S)

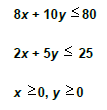

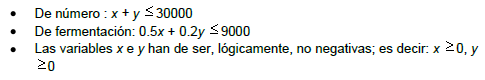

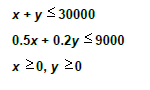

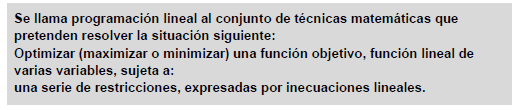

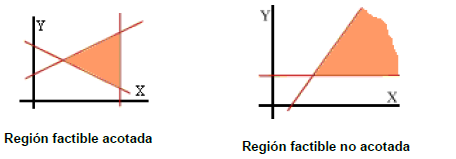

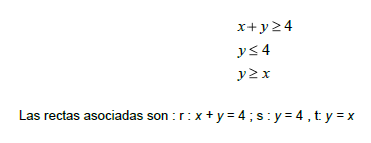

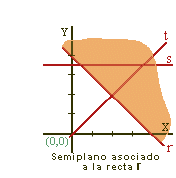

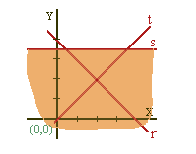

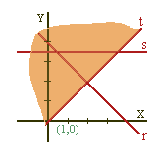

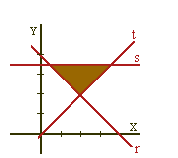

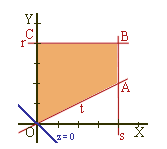

3.1 Determinación de la región Factible.

3.5 Características de las Operaciones Deterministas.

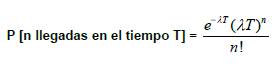

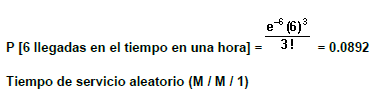

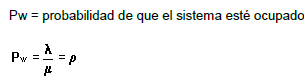

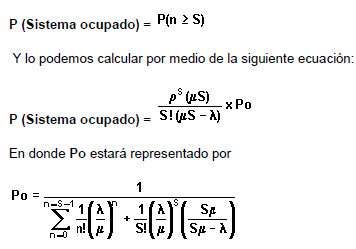

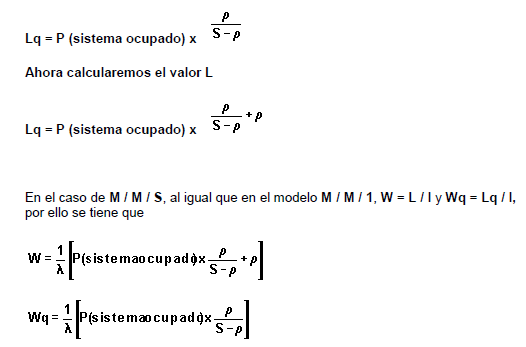

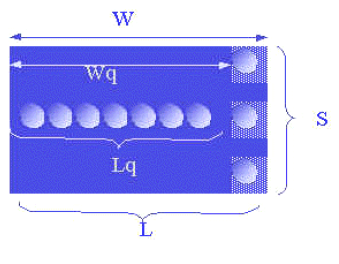

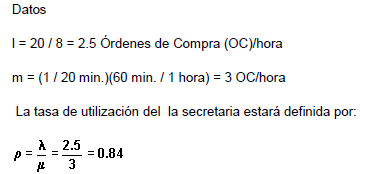

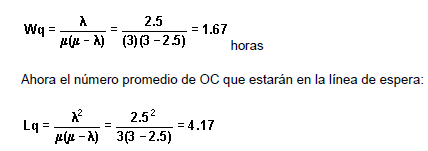

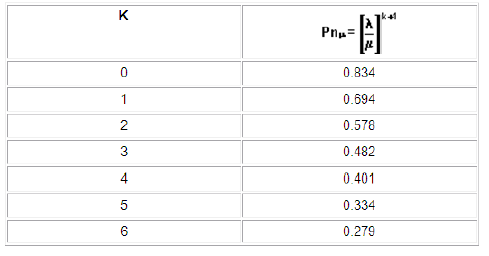

3.7 características del Modelo M/M/S

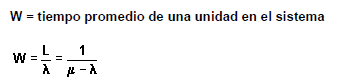

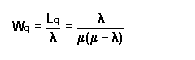

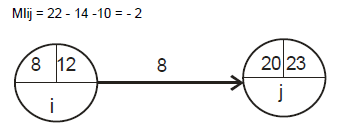

Figura 3.1 se representa el Modelo

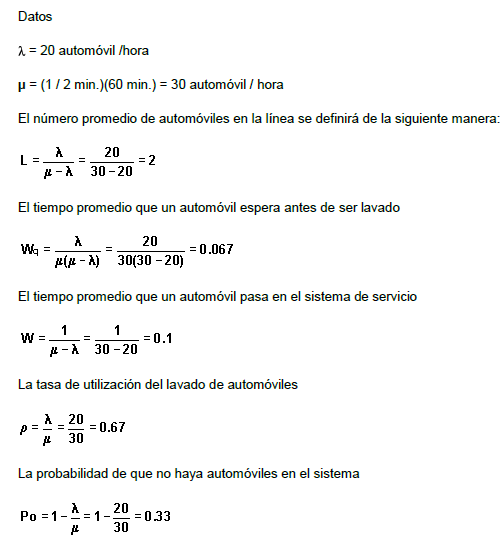

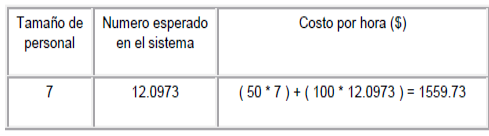

3.9 Modelo y análisis del Sistema de Cola Actual.

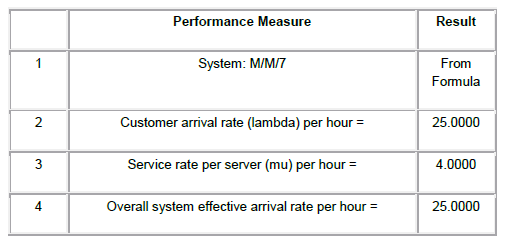

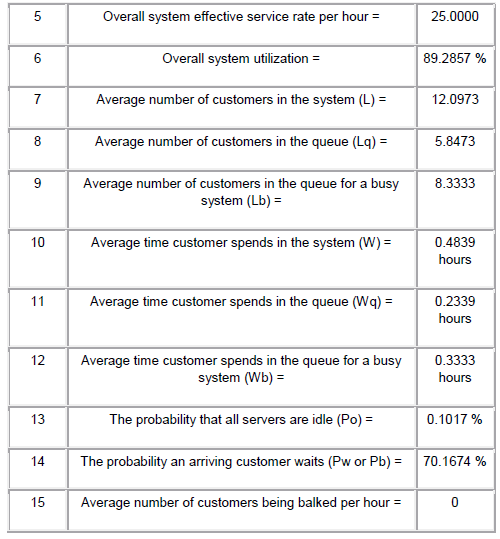

Rendimiento obtenidas con Queuing Analysis „ en el WinQSB .

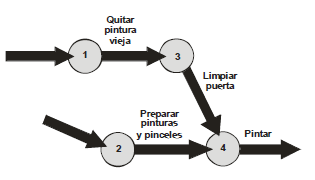

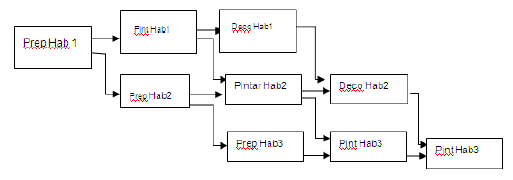

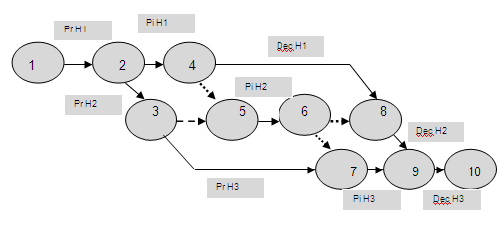

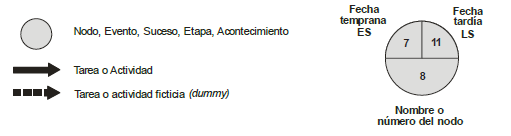

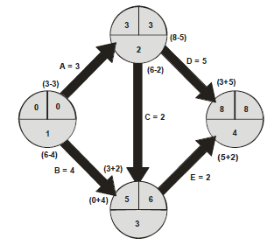

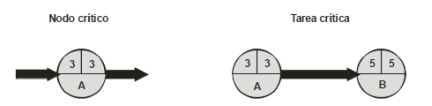

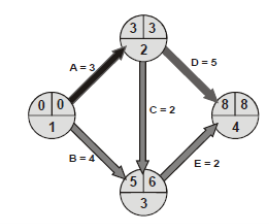

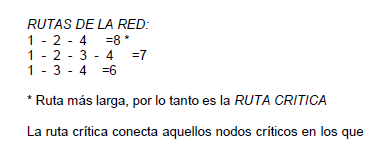

4.1 La Administración de Proyectos.

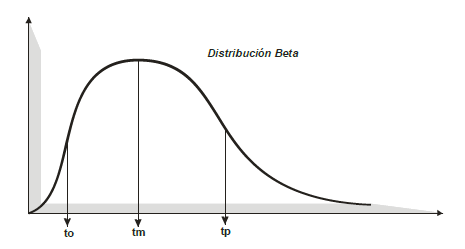

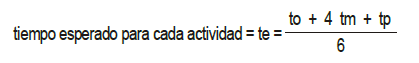

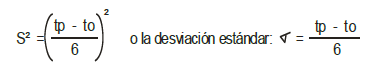

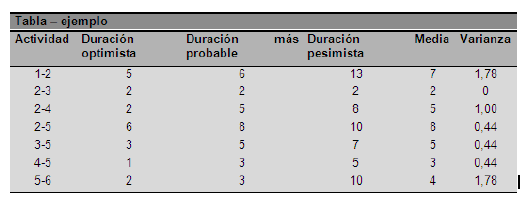

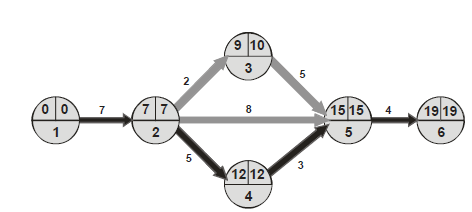

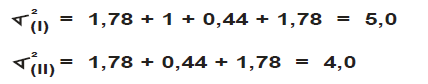

4.2 La Situación Probabilística.

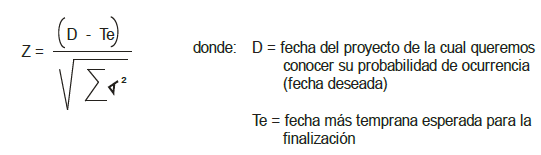

4.3 Análisis de las Probabilidades.

PRÓLOGO

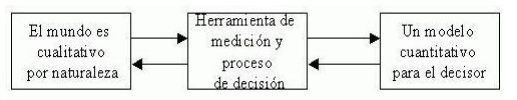

Un enfoque progresivo del modelado es esencial en el proceso de toma de decisiones. Este enfoque involucra a dos partes clave: quien toma las decisiones y quien construye el modelo, a quien a menudo se le llama analista. El analista juega un papel crucial al ayudar a quien toma las decisiones durante todo el proceso de toma de decisiones. Para cumplir eficazmente este papel, el analista debe poseer algo más que un conjunto de métodos analíticos; también deben poseer una comprensión integral del proceso de toma de decisiones. El análisis de decisiones ofrece una herramienta valiosa para quienes EMITEN fallos en una amplia gama de campos, incluidos ingenieros, planificadores, agencias públicas, gerentes de proyectos, analistas financieros y expertos en diversas disciplinas médicas y tecnológicas.

Su soporte cuantitativo permite a estos profesionales tomar decisiones informadas en sus respectivas áreas de especialización. En el campo de la construcción de modelos, los expertos a menudo se sienten atraídos por investigar a fondo un problema antes de retirarse a sus propias mentes para construir un modelo matemático para que lo utilice el gerente o la persona que toma las decisiones, surge un desafío importante cuando el gerente carece de una comprensión completa de las complejidades del modelo. Esto podría dar como resultado que el gerente implemente ciegamente el modelo sin comprender sus principios subyacentes o lo rechace rotundamente. Esta desconexión entre el especialista y el gerente a veces puede generar una sensación de frustración en ambas partes. El especialista puede percibir que el gerente está alarmantemente desinformado y carente de sofisticación al intentar evaluar el modelo, mientras que el gerente puede considerar que el especialista habita en un mundo de suposiciones poco prácticas y utiliza una jerga matemática compleja que parece irrelevante para el escenario del mundo real en cuestión.

Estos desafíos de malentendidos y comunicación ineficaz pueden evitarse si el gerente colabora estrechamente con el especialista en el desarrollo de un modelo básico que ofrezca un análisis aproximado pero comprensible. Una vez que el gerente se sienta cómodo con el modelo, se pueden incorporar gradualmente y con cautela más detalles y una mayor sofisticación. Este procedimiento exige la inversión de tiempo del administrador y el compromiso genuino del analista para resolver los problemas reales del administrador, en lugar de intentar crear y explicar modelos excesivamente complejos. Esta construcción gradual del modelo, a menudo conocida como enfoque de arranque, es el determinante clave de un modelo de decisión de implementación exitoso, el enfoque de arranque simplifica las complejidades involucradas en la validación y verificación del modelo. Un sistema puede definirse como un conjunto de componentes interconectados que funcionan juntos de manera coordinada para lograr un objetivo específico. Es la interdependencia y la interacción entre estos componentes lo que en última instancia determina el funcionamiento general y el propósito del sistema. En consecuencia, las relaciones y conexiones dentro del sistema suelen tener mayor importancia que los componentes individuales por sí solos. Además, cuando los sistemas se construyen combinando unidades o subsistemas más pequeños, se les denomina subsistemas dentro del sistema más grande. La dinámica de un sistema: un sistema que permanece sin cambios se considera estático o determinista. Sin embargo, la mayoría de los sistemas que encontramos son de naturaleza dinámica, lo que significa que sufren cambios con el tiempo, estos cambios se basan en el comportamiento exhibido por el sistema.

Si el sistema sigue un patrón de desarrollo predecible, nos referimos a él como si tuviera un patrón de comportamiento. El hecho de que un sistema sea estático o dinámico depende del marco temporal de estudio y de las variables específicas que son el foco del análisis. El horizonte temporal se refiere al tiempo durante el cual se observa y examina el sistema, mientras que las variables son los valores ajustables dentro del sistema. En los modelos deterministas, la evaluación de la calidad de una decisión se basa únicamente en sus resultados. Sin embargo, en los modelos probabilísticos la evaluación del directivo va más allá de los resultados y también toma en consideración el nivel de incertidumbre o riesgo asociado a cada decisión. Para ilustrar la distinción entre modelos probabilísticos y deterministas, consideremos los reinos del pasado y el futuro.

Cuando se trata del pasado, sin importar nuestras acciones en el presente, no podemos alterar lo que ya ocurrió. Por otro lado, cuando nos centramos en el futuro, nuestras elecciones y decisiones tienen la capacidad de ejercer influencia y provocar cambios, aunque siga existiendo un cierto nivel de incertidumbre. Como directivos, a menudo nos sentimos cautivados por la oportunidad de dar forma al futuro, dándole mayor importancia que el análisis y la insistencia en acontecimientos pasados. El concepto de probabilidad ocupa un lugar importante en el proceso de toma de decisiones, ya sea dentro de una empresa, el gobierno, las ciencias sociales o nuestra vida cotidiana. Es raro tener toda la información necesaria disponible al tomar decisiones, y la mayoría de las decisiones se toman en medio de la incertidumbre.

A diferencia de los procesos de toma de decisiones determinísticas tal como, optimización lineal resuelta mediante sistema de ecuaciones, sistemas paramétricos de ecuaciones y en la toma de decisión bajo pura incertidumbre, las variables son normalmente más numerosas y por lo tanto más difíciles de medir y controlar, los pasos para resolverlos son los mismos. El modelo es una representación simplificada de la situación real, no necesita estar completo o exacto en todas las relaciones. Este se entiende con mayor facilidad que un suceso empírico (observado), por lo tanto permite que el problema sea resuelto con mayor facilidad y con un mínimo de esfuerzo y pérdida de tiempo. El modelo puede usarse repetidamente para problemas similares, y además puede ajustarse y modificarse, afortunadamente, los métodos probabilísticos y estadísticos para analizar la toma de decisiones en condiciones de incertidumbre son mucho más numerosos y poderosos que nunca. Las computadoras ofrecen muchos usos prácticos. Algunos ejemplos de aplicaciones comerciales son los siguientes: Un auditor puede utilizar técnicas de muestreo aleatorio para auditar las cuentas por cobrar de un cliente. Un gerente de planta puede utilizar técnicas de control de calidad para asegurar la calidad de los productos con mínima inspección y menor número de pruebas. Un analista financiero podría usar métodos de regresión y evaluación para entender mejor la analogía entre los indicadores financieros y un conjunto de otras variables de negocio. Un analista de mercado podría usar pruebas de significancia para aceptar o rechazar una hipótesis sobre un grupo de posibles compradores a los cuales la compañía está interesada en vender sus productos, un gerente de ventas podría usar técnicas para predecir las ventas de los próximos períodos.

CAPÍTULO I

MODELOS PROBABILÍSTICOS

1. LA INVESTIGACIÓN DE OPERACIONES.

La investigación de operaciones ha demostrado ser exitosa en muchas organizaciones, pero todavía hay escépticos que no reconocen su valor, para abordar esto es necesario un cambio en la forma de enseñar y presentar la Investigación Operativa, enfatizando su aplicación práctica en las organizaciones. A los directivos, que estaban más alejados de las matemáticas en el aula que los investigadores, les resultó difícil aplicar estos algoritmos en situaciones de toma de decisiones de la vida real, la solución manual de un problema de decisión mediante un algoritmo Simplex puso de relieve la dificultad del proceso, la baja relación costo/beneficio y la complejidad de las situaciones de la vida real hicieron que los gerentes prefirieran criterios más heurísticos y descartaran los enfoques matemáticos. Esto resultó en una división entre la toma de decisiones y la ciencia y la tecnología. La investigación de operaciones, también conocida como ciencia de la gestión, ha sido un campo bien establecido durante más de un siglo y sus orígenes se remontan a principios del siglo XX.

Su prominencia alcanzó su punto máximo al final de la Segunda Guerra Mundial, cuando el mundo experimentaba una rápida industrialización y una alta demanda. A medida que las técnicas de investigación de operaciones se aplicaron a las organizaciones, el campo se expandió más allá de los matemáticos e ingenieros para incluir profesionales en administración y economía, a medida que los escenarios económicos globales cambiaron (pasando de una economía basada en la oferta a una basada en la demanda) y entraron en juego factores adicionales (como la introducción de más restricciones y criterios de decisión más allá del costo), la efectividad de estos algoritmos comenzó a disminuir ser cuestionado.

Esta división hizo que los profesionales de la gestión, especialmente los administradores, perdieran valiosas herramientas para la toma de decisiones. Sin embargo, la revolución informática cerró esta brecha al permitir que las metodologías y el software matemáticos fueran accesibles para los usuarios. Las computadoras permitieron la integración de la ciencia con la toma de decisiones, permitiendo a los gerentes utilizar enfoques matemáticos y evaluar resultados basados en su conocimiento de la situación. En pocas palabras, la Investigación de Operaciones se basa en dos premisas fundamentales: enseñar a las personas cómo modelar y pensar sistémicamente sobre una situación y proporcionarles una variedad de herramientas informáticas para ayudar a encontrar soluciones, si bien no pretende ser original en su contenido teórico debido a la gran cantidad de literatura existente sobre el tema, pretende recopilar diversos artículos, trabajos y notas.

Muchos de estos recursos provienen de la fascinante aldea global de Internet. Considero que la Investigación Operativa es una herramienta vital para la toma de decisiones, particularmente para los estudiantes de administración. Son los actores principales que entienden los entresijos de una organización o de su área específica. Es fundamental involucrar a los tomadores de decisiones en la construcción del modelo para asegurar su uso efectivo. La Investigación de Operaciones no se limita a matemáticos o informáticos; es un campo dinámico y apasionante dentro de la gestión organizacional donde los futuros profesionales prosperarán. Durante este tiempo, la atención se centró en encontrar soluciones para sistemas militares complejos y empresas que tomaban decisiones basándose únicamente en los costos.

El mercado pudo absorber importantes volúmenes de producción, lo que permitió el desarrollo de técnicas y algoritmos matemáticos para resolver problemas con diversas restricciones. Estas técnicas fueron ampliamente aceptadas y exitosas en el entorno económico de la época. Un ejemplo notable es el método Simplex, que fue desarrollado por G. Dantzing en 1947, este restableció la importancia de la Investigación Operativa en la gestión, ofreciendo herramientas para ayudar a la toma de decisiones con rapidez y sencillez, destacó que la preparación e interpretación del modelo siguen siendo tareas cruciales para quien toma las decisiones.

La investigación de operaciones, también conocida como IO, es un campo que se centra en la resolución de problemas y la toma de decisiones dentro de las organizaciones, abarca una amplia gama de industrias, incluidas la manufactura, el transporte, las telecomunicaciones, las finanzas, la atención médica y el ejército, la IO utiliza un enfoque científico similar a los campos científicos establecidos, utilizando observación cuidadosa, recopilación de datos y la construcción de modelos matemáticos para representar problemas del mundo real. Luego, estos modelos se prueban mediante experimentos para validar su precisión y eficacia I no sólo implica investigación e investigación científica, sino también administración práctica y proporcionar conclusiones claras para los tomadores de decisiones.

Se necesita un punto de vista organizacional, con el objetivo de resolver conflictos de intereses y lograr los mejores resultados para toda la organización, uno de los objetivos clave de la IO es encontrar soluciones óptimas para los problemas actuales, considerando varios factores y perspectivas. Debido a la complejidad y la naturaleza multidisciplinaria de la IO, requiere la experiencia de personas de diversos orígenes, incluidas matemáticas, estadística, economía, administración de empresas, informática, ingeniería, ciencias físicas y ciencias del comportamiento. La colaboración de equipos interdisciplinarios es esencial para la resolución integral de problemas y considerar todas las implicaciones del problema en toda la organización. La definición internacionalmente aceptada de IO enfatiza su aplicación de métodos científicos a problemas complejos en la gestión de grandes sistemas, incorporando mediciones de factores como el cambio y el riesgo para predecir y comparar decisiones, estrategias o controles alternativos. En última instancia, el propósito de la IO es ayudar a la gerencia a formular políticas y acciones informadas y respaldadas científicamente.

![]() 1.1 Modelos de la Investigación de Operaciones.

1.1 Modelos de la Investigación de Operaciones.

Un enfoque sistemático para la resolución de problemas, con un enfoque en colaborar como equipo para aprovechar la experiencia de los especialistas de IO en la evaluación, coordinación e incorporación de conocimientos relevantes proporcionados por expertos en otros campos, todo con el objetivo de resolver un problema específico. problema (también conocido como enfoque de grupo de expertos). El proceso de modelado estructurado juega un papel central en la investigación de operaciones, sirviendo como actividad principal. Esto nos lleva a preguntarnos si el modelo representa con precisión el mundo real, si bien el modelo no es un reflejo directo de la realidad, sí incorpora ciertos elementos. Esto plantea otra pregunta importante: ¿incluye el modelo las partes relevantes necesarias para resolver el problema de decisión en cuestión? El razonamiento y los cálculos simbólicos son fundamentales en el proceso de modelado analítico, al igual que en matemáticas.

Por lo tanto, al igual que cuando se aprende un idioma extranjero, es necesario desarrollar una comprensión de las matemáticas, ya que es el lenguaje de todas las ciencias, incluido el proceso de modelado en IO, cuyo objetivo es ayudar a los tomadores de decisiones. Un modelo mental representa los pensamientos de quien toma decisiones con respecto a la realidad, esencialmente exteriorizando su percepción, los matemáticos utilizan símbolos y notaciones, incluidos números, para crear modelos, así, tenemos tres conceptos distintos: la realidad, el modelo mental y su representación. En todas sus formas, el modelado analítico es un proceso de pensamiento estructurado que implica reconocer y articular un problema, y posteriormente cuantificarlo traduciendo palabras en expresiones matemáticas, el modelado sirve como un proceso de pensamiento enfocado y secuencial que ayuda a comprender los problemas de decisión.

Al adoptar un enfoque científico, los administradores pueden hacer predicciones precisas incluso en situaciones sobre las que no tienen control total, la información cualitativa se puede caracterizar y procesar mediante asignación numérica, utilizamos varias escalas numéricas y mensurables para cuantificar el mundo. Podemos obtener una comprensión del mundo identificando relaciones y utilizando manipulación, comparación, cálculo y otros métodos, y luego usando las mismas escalas para adaptar nuestros hallazgos al mundo real.

Gráfico 1.1

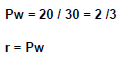

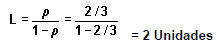

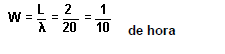

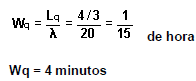

La necesidad de una escala numérica y mesurable.

Fuente: Carro, (2009).

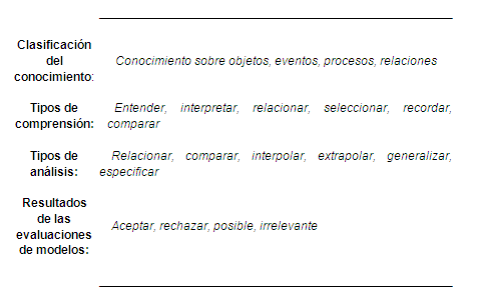

Tabla 1.2

Clasificación de las características.

Fuente: Carro, (2009).

1.2 La Modelización en la toma de Decisiones.

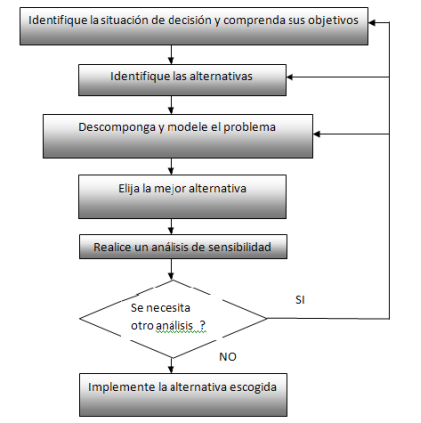

El procedimiento general para el proceso de toma de decisiones sigue los pasos bien conocidos descritos en la teoría de la gestión. Estos pasos incluyen describir el problema, recomendar una solución y monitorear el problema mediante la evaluación y actualización continua de la solución estratégica, con el fin de adaptarse a las condiciones cambiantes del negocios importante señalar que siempre existe un circuito de retroalimentación entre estos tres pasos. Cuando se identifica un problema, es fundamental analizarlo y comprenderlo antes de describirlo con precisión por escrito. Esto puede implicar el desarrollo de un modelo o marco matemático que represente con precisión la realidad, con el fin de idear posibles soluciones.

Es importante validar el modelo antes de ofrecer una solución. Este proceso requiere la capacidad de considerar múltiples perspectivas para acercarse lo más posible a la realidad. Combinando diferentes modelos desde diversas perspectivas, se puede lograr una mejor comprensión del problema. Es esencial ser específico y no abstracto en la toma de decisiones. Identificar los factores que influyen en la decisión y determinar qué está bajo control y qué no es crucial. A menos que el problema haya sido claramente formulado por el científico de la administración y aceptado como propio por quien toma las decisiones, es probable que la solución estratégica sea rechazada.

En algunos casos, la solución estratégica a un problema existente puede crear nuevos problemas, el proceso de modelado en IoT por sí solo no puede resolver los problemas de decisión; su principal objetivo es generar ideas y fomentar la creatividad para ayudar a los responsables de la toma de decisiones a tomar la decisión "correcta". El aspecto más crítico de la toma de decisiones es comprender el problema. Generalmente la formulación de un problema es más importante que su solución. De hecho, si uno puede comprender el problema, a menudo proporciona ideas sobre cómo resolverlo. En relación con la importancia de la comunicación en el modelado de IoT, se ha observado que las personas tienden a complicar las cosas innecesariamente.

Esta cuestión es particularmente destacada en los informes escritos, existe un temor común a parecer poco sofisticado o poco inteligente si uno elige escribir de manera directa y sencilla. En consecuencia, el resultado final es un producto incomprensible para quien toma las decisiones. Para superar esto, el análisis debe realizarse por etapas, con el objetivo de producir un informe que sea fácilmente comprensible para todos los lectores. Este proceso de toma de decisiones se parece mucho al enfoque estructurado que se sigue en el tratamiento de una enfermedad. Cuando un paciente se encuentra con un problema de salud, busca la ayuda de un médico para encontrar una solución. El médico, en colaboración con el paciente, describe el problema realizando pruebas o exámenes para diagnosticar la enfermedad.

Luego, el médico prescribe medicamentos y realiza visitas de seguimiento para garantizar que la acción elegida esté curando eficazmente al paciente. Si es necesario, el médico realizará cambios en la medicación. En esta analogía, el médico representa al profesional de IoT, mientras que el paciente simboliza a quien toma las decisiones y es dueño de los problemas una decisión es una elección racional hecha entre diferentes opciones es un aspecto crucial de la resolución de problemas, que cae dentro del campo más amplio de la gestión. Si bien se pueden desarrollar modelos matemáticos utilizando la ciencia de la gestión, se vuelven inútiles si la comunicación de los resultados es demasiado complicada para que la comprenda quien toma las decisiones.

La prescripción de una solución implica identificar una solución estratégica e implementarla. Se debe buscar una solución estratégica utilizando las técnicas de solución disponibles en IoT, que se discutirán más adelante. Todo problema de decisión gerencial tiene múltiples soluciones. El objetivo es lograr una solución estratégica satisfactoria, a menudo denominada "decisión correcta". No existe una solución única para los problemas del mundo real las soluciones dependen de factores como el presupuesto, el tiempo y diversas limitaciones y condiciones.

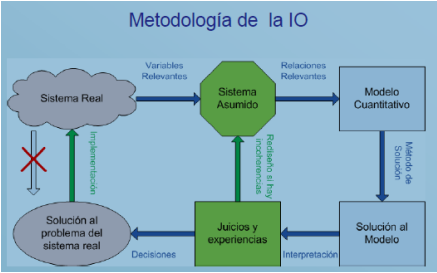

Gráfico 1.2

Descripción de la Metodología

La validación del modelo es el proceso de comparar el resultado del modelo con el comportamiento del fenómeno en la realidad, implica preguntarse si el modelo que hemos construido es el adecuado para el uso previsto. La validación reconoce que ningún modelo puede capturar perfectamente todos los detalles de un sistema real y requiere determinar qué grado de desviación entre el modelo y la realidad es aceptable para el propósito previsto. La verificación del modelo, por otro lado, es el proceso de comparar el programa de computadora con el modelo para garantizar que el programa esté implementando correctamente el modelo. Hay varias razones por las que un modelo puede fallar en la validación, como la complejidad que dificulta la verificación adecuada.

En tales casos, puede ser necesario simplificar el modelo convirtiendo variables en constantes, eliminando variables, utilizando relaciones lineales en lugar de relaciones no lineales, agregando suposiciones y restricciones más estrictas o eliminando factores aleatorios. El problema de la toma de decisiones a menudo se presenta de manera distante e impersonal por parte de quien toma las decisiones, para encontrar una solución, los técnicos analizan el problema e identifican el módulo de software adecuado a utilizar. Sin embargo, es importante presentar la solución estratégica a quien toma las decisiones de una manera que pueda comprenderla, en lugar de simplemente proporcionar resultados impresos desde la computadora.

Esto requiere una interpretación gerencial de la solución, utilizando un lenguaje no técnico, a diferencia de las ecuaciones matemáticas que tienen una única solución correcta, los problemas de la vida real no tienen una respuesta definitiva. No se pueden resolver de una vez por todas, sino que requieren actualizaciones y ajustes continuos. El proceso de modelado en IO, por lo tanto, no es una ciencia exacta como las matemáticas, sino más bien un proceso en el que las decisiones deben ser tomadas en última instancia por quien toma las decisiones, las actividades de seguimiento posteriores a la prescripción desempeñan un papel crucial en el control del problema.

En un mundo en constante cambio, es necesario actualizar periódicamente las soluciones a los problemas que surgen. Incluso una solución que es válida ahora puede quedar obsoleta debido a cambios en las condiciones, convirtiéndola en una representación inexacta de la realidad. Esto puede afectar negativamente la capacidad de quien toma las decisiones para tomar las decisiones correctas, cualquier modelo utilizado debe ser capaz de adaptarse y responder a los cambios. No se debe pasar por alto la importancia de la retroalimentación y el control en el proceso de toma de decisiones, sería un error ignorar el hecho de que no existe una solución permanente para un problema de decisión empresarial. La naturaleza misma del entorno en el que se toman las decisiones es de cambio constante, lo que hace que la retroalimentación y el control sean componentes esenciales del proceso de modelado en IO.

Durante la validación, el profesional de IoT pregunta cómo se relaciona el modelo con el mundo real, los modelos que no se van a implementar ni tomar en serio desde el principio no se desarrollan correctamente. Es importante analizar y revisar cuidadosamente la información y su vigencia en el momento en que se recibe. Una vez obtenido un modelo válido, éste puede utilizarse como herramienta para la toma de decisiones, implementar el modelo no es una tarea sencilla y no debe darse por sentado, el desarrollador debe considerar cuidadosamente cómo poner el modelo en práctica y utilizarlo de forma eficaz.

Esto resalta la importancia de involucrar a quien toma las decisiones en todos los pasos del proceso de construcción del modelo, especialmente cuando el desarrollador y la persona que toma las decisiones no son la misma persona. Al incluir a quien toma las decisiones, aumentan considerablemente las posibilidades de que el modelo se implemente adecuadamente. Sin embargo, también deben tenerse en cuenta consideraciones de costes. Construir un modelo puede ser una tarea costosa. Puede que no sea prudente invertir una cantidad significativa de dinero, como 500 000 dólares, en el desarrollo de un modelo que sólo produce un rendimiento de 50 000 dólares. La razón de este alto costo radica en la

La complejidad de un modelo matemático puede aumentar con el tiempo a medida que se le incorporan más entradas y restricciones. Identificar y relacionar adecuadamente estos elementos dentro del modelo requiere una cantidad significativa de tiempo y esfuerzo, ya que debe capturar con precisión las complejidades de un sistema complejo, a medida que el modelo se vuelve más complejo, también aumenta la probabilidad de errores o interpretaciones erróneas. Esto puede dar como resultado que el modelo represente de manera inexacta la realidad o produzca resultados completamente falsos. Estas imprecisiones pueden tener graves consecuencias para la toma de decisiones y el éxito general de una empresa. Por lo tanto, es crucial garantizar la precisión al definir y expresar un problema matemáticamente, la aceptación de un modelo durante su implementación también es de gran importancia.

Si el individuo que debe utilizar el modelo no lo acepta, entonces su valor disminuye. Esta falta de aceptación puede deberse a varios factores, como una falta de comprensión del modelo o de las técnicas utilizadas para resolverlo por parte de quien toma las decisiones, o una falta de comprensión del gestor y su entorno específico por parte del desarrollador del modelo. Estos factores, incluidas las preguntas, el lenguaje y los criterios del gerente, desempeñan un papel vital a la hora de determinar qué se considera importante en el modelo. Al utilizar estas estrategias, es posible superar las limitaciones del proceso de modelado analítico y crear modelos que representen y resuelvan eficazmente problemas del mundo real. Para que los modelos contribuyan eficazmente a la toma de decisiones empresariales, es esencial comprender los beneficios y las complejidades tanto del modelo en sí como del proceso de construcción.

Para comprender plenamente la importancia de las técnicas de toma de decisiones empleadas en la organización industrial (IO), es necesaria una comprensión clara del papel del modelo y los pasos involucrados en su creación. Un aspecto clave del uso exitoso de modelos es reconocer que son abstracciones; su propósito no es proporcionar una solución definitiva a un problema de decisión, sino más bien ofrecer información valiosa que ayude en la toma de decisiones. Es importante que el modelo logre un equilibrio, evitando la replicación de todas las complejidades de la realidad, ya que esto dificultaría su resolución y proporcionaría conocimientos limitados para quien toma las decisiones, el modelo tampoco debería simplificarse demasiado hasta el punto de perder su conexión con el mundo real. Este equilibrio se aplica a todo tipo de modelos, ya sean verbales, mentales o matemáticos, ya que todos constan de variables independientes, variables dependientes, parámetros y constantes. Los modelos verbales tienen la ventaja de poder reunir estos elementos de forma natural e intuitiva, ayudando a la comprensión y la comunicación efectiva, a medida que pasamos de modelos verbales a modelos mentales y matemáticos, se hace necesario definir estos elementos con mayor precisión.

El proceso de construcción del modelo es un proceso iterativo. Desarrollar un modelo utilizable no es una tarea que pueda lograrse en un solo intento, ni siquiera para el desarrollador de modelos más experimentado. Más bien, es un proceso que implica formular y validar el modelo, seguido de posibles intentos de reformulación y revalidación. Este proceso iterativo continúa hasta que se logra un cierto nivel de confianza en la utilidad del modelo. La razón por la que diferentes gerentes toman decisiones diferentes cuando se enfrentan al mismo problema radica en el hecho de que todos somos individuos únicos con diferentes experiencias y orígenes. Las experiencias de vida de cada persona moldean su mente de una manera distinta, y el conocimiento en sí es un fenómeno biológico. Como resultado, cada ser humano percibe e interactúa con el mundo a su manera. A través de sus procesos cognitivos internos, cada individuo entabla una relación creativa con el mundo externo, contribuyendo a la amplia gama de miles de modelos diferentes.

1.4 Algunas diferencias entre el Diseño y la Materialización del Modelo.

La existencia y crecimiento de la brecha entre la teoría y la aplicación de modelos para la toma de decisiones puede atribuirse a varios factores. En primer lugar, los problemas reales suelen ser difíciles de definir y analizar, lo que dificulta la creación de modelos precisos, si bien puede ser más fácil desarrollar planes, la implementación de estos modelos a menudo se pasa por alto o no se le da la debida consideración. Esta falta de preparación desde el principio conduce a una utilización ineficaz de los modelos. Otro factor que contribuye es la falta de colaboración estrecha entre el creador del modelo y el propietario del problema. Las organizaciones a menudo no ven los beneficios directos e inmediatos de la colaboración, lo que lleva a una falta de confianza en la capacidad del modelo para resolver el problema sin causar ningún daño.

Se puede facilitar el establecimiento de confianza y el fomento de la voluntad de cooperar compartiendo experiencias de casos anteriores, la disponibilidad de datos plantea un desafío importante, ya que a menudo están dispersos, incompletos e inexactos. Para ahorrar costos y lograr resultados más rápidos, algunas empresas se conforman con resultados aproximados que se basan en datos limitados y más suposiciones. Este enfoque puede ahorrar tiempo y dinero en la recopilación de datos, pero compromete la precisión y confiabilidad de los resultados, es necesario influir en la cultura y la actitud hacia el diseño de modelos dentro de la comunidad empresarial. Esto requiere gerentes mejor capacitados y equipados para comprender y utilizar modelos analíticos de manera efectiva.

Desafortunadamente, muchas empresas invierten mucho en promociones de marketing, pero sólo asignan recursos mínimos para estudiar la eficacia de estos esfuerzos, los gerentes a menudo carecen de la capacitación adecuada en los conceptos y el uso de modelos analíticos, lo que contribuye aún más a la brecha entre la teoría y la aplicación. Es crucial que los modeladores aborden los problemas que los gerentes consideran importantes desde una perspectiva de ahorro de costos, ya que esto aumentará la probabilidad de una implementación y utilización exitosa de los modelos.

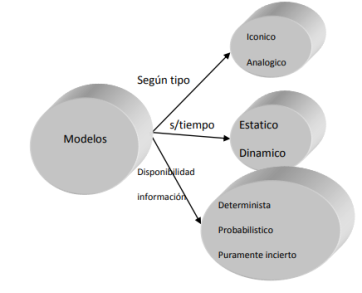

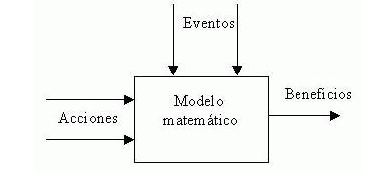

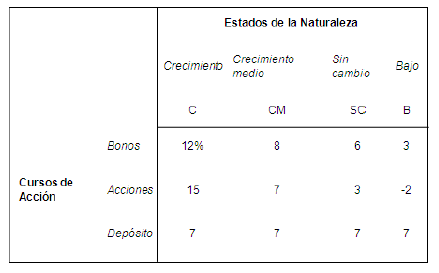

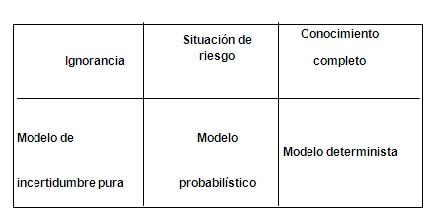

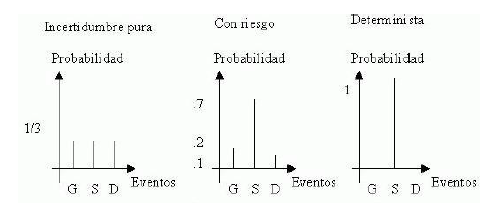

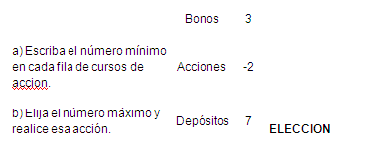

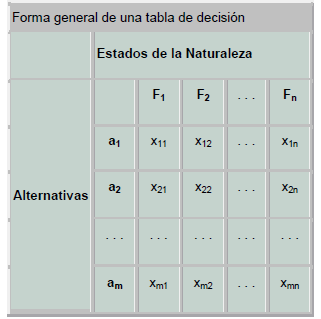

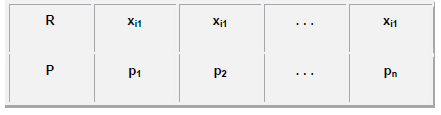

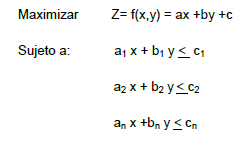

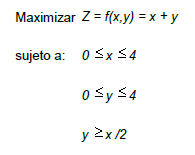

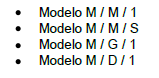

Los modelos de toma de decisiones se pueden dividir en dos categorías principales: modelos deterministas y modelos probabilísticos. En los modelos deterministas, las buenas decisiones se toman en función de sus resultados positivos, sin ningún riesgo involucrado. Los resultados de una decisión están influenciados por factores no controlables y la capacidad de quien toma la decisión para controlar estos factores a través de la información disponible. Por otro lado, los modelos probabilísticos tienen en cuenta tanto el valor del resultado como el nivel de riesgo asociado a cada decisión. Quien toma las decisiones debe determinar qué tipo de modelo es el más adecuado para el problema en cuestión. Por tanto, es importante analizar y clasificar diferentes modelos antes de proceder con el proceso de toma de decisiones. Si bien IoT se centra principalmente en modelos matemáticos, existen otros tipos de modelos que se utilizan ampliamente en la práctica. Estos modelos se pueden clasificar en función de diversas características, como su tipo, cómo evolucionan en el tiempo y la disponibilidad de información, este proceso de clasificación se ilustra en el siguiente Gráfico.

Gráfico 1.3

Modelos

Fuente: Carro, (2009).

Los modelos mentales/verbales son traducciones de modelos mentales al lenguaje. Expresan las relaciones funcionales entre variables. Por ejemplo, un director de publicidad podría expresar su creencia de que un comercial de 20 segundos tiene más impacto en el público objetivo que uno de 15 segundos. Los modelos mentales/verbales son fáciles de entender y a menudo son el resultado de años de experiencia gerencial. Sin embargo, tienen limitaciones. Los tomadores de decisiones no pueden experimentar con ellos y no brindan información específica sobre cómo cambian los resultados o las medidas de efectividad con diferentes alternativas de decisión. Los modelos mecánicos, también conocidos como modelos físicos, se parecen a los objetos que representan, se utilizan para mostrar o probar el diseño de diversos elementos, desde nuevas construcciones hasta nuevos productos. Por ejemplo, en la industria de la aviación, se construyen y prueban modelos a escala de aviones en túneles de viento para analizar su aerodinámica.

De manera similar, los fabricantes de repuestos para automóviles pueden tener modelos a escala tridimensional de su planta para estudiar nuevos diseños de distribución y mejorar el flujo de materiales. Los modelos mecánicos ofrecen la ventaja de la experimentación y pueden ayudar a generar soluciones de diseño innovadoras. Sin embargo, su capacidad para resolver ciertos problemas, como la selección de cartera, la selección de medios para publicidad y la planificación de la producción, es limitada. En estos casos, los modelos matemáticos ejecutados en computadoras proporcionan un análisis más eficiente y completo. Los modelos analíticos son modelos matemáticos que simplifican y abstraen sistemas reales para obtener una comprensión más profunda de ciertos aspectos de la realidad.

Estos modelos se aplican principalmente a sistemas estáticos y deterministas. En comparación con los modelos mecánicos, los modelos matemáticos facilitan la experimentación ya que todas las variables, constantes y parámetros están relacionados explícitamente a través del lenguaje matemático. Los tomadores de decisiones pueden probar fácilmente los efectos de diferentes variables, estos modelos deben conectarse a problemas y dominios reales y verificarse y validarse mediante la práctica, existen varios tipos de modelos utilizados en diferentes contextos. Cada tipo tiene sus ventajas y limitaciones, y la elección del modelo depende del problema específico que se aborde. Los modelos icónicos suelen ser de naturaleza estática y física, pero a menudo no representan con precisión la realidad. Se utilizan principalmente en sistemas mecánicos. Por otro lado, las actividades empresariales son procesos dinámicos que siguen patrones matemáticos. Como resultado, pueden representarse mediante modelos simbólicos como los modelos algebraicos, numéricos y lógicos, entre estos modelos simbólicos, se utilizan ampliamente los modelos matemáticos y de simulación por computadora.

Un modelo de decisión es una representación simbólica de la realidad, con ciertas variables que representan las decisiones que se pueden tomar. Se trata de formular una representación de la realidad y determinar los aspectos relevantes. Por ejemplo, en un análisis de relevancia de un modelo real para una empresa, pueden surgir preguntas como si las ganancias son un insumo o una medida del desempeño, si el precio de un producto es una decisión o un parámetro, si la cantidad de producto a ser vendido es una variable de insumo o de producto, si la moral de los trabajadores es una medida del desempeño o un parámetro, cómo se puede medir la moral (por ejemplo, utilizando el ausentismo) y si la participación de mercado es una medida del desempeño y, de ser así, debería medirse. en unidades vendidas o ingresos. Por ejemplo, en el modelo normativo-estático-determinista con variables de decisión continuas, relaciones lineales y el objetivo de encontrar la solución óptima, la técnica de solución potencial se limitaría a la programación lineal.

El lenguaje de las matemáticas ofrece numerosas ventajas para los tomadores de decisiones. Los modelos matemáticos permiten probar fácilmente diferentes alternativas de decisión, constantes y valores de parámetros en variables dependientes. También son eficientes y concisos a la hora de representar problemas complejos, lo que los convierte en una forma rentable de analizar problemas. Por lo tanto, es importante analizar diversos modelos matemáticos y técnicas de solución que se utilizan comúnmente en la práctica. Los procedimientos de solución se pueden clasificar como de paso único o iterativos. En los procedimientos de un solo paso, los valores finales de todas las variables de decisión se determinan simultáneamente mediante un procedimiento bien definido.

Por otro lado, las técnicas de solución iterativa implican una serie de pasos para llegar a una solución final, obteniéndose soluciones parciales o completas en cada paso. La solución óptima es aquella que ha demostrado ser al menos tan buena como cualquier otra, según los supuestos del modelo, mientras que una solución satisfactoria se considera "buena" con respecto a los objetivos y restricciones, pero puede no ser la mejor. Los modelos de simulación enfrentan desafíos en su aceptación por parte de los gerentes debido a su nivel de abstracción. Los gerentes que carecen de suficiente capacitación o exposición a estos modelos, así como aquellos que están capacitados pero no tienen tiempo para brindarles la atención adecuada, pueden resistirse a su uso. Los modelos matemáticos tienen sus limitaciones debido al lenguaje simbólico de las matemáticas.

Los modelos analógicos, si bien están diseñados para imitar la realidad, pueden no parecerse mucho a ella. Los modelos complejos, como los que involucran un aeropuerto internacional, pueden requerir simplificaciones significativas para resolverse de manera eficiente, desviándose potencialmente del problema original y provocando efectos desastrosos en la organización. Por lo tanto, es necesaria una selección cuidadosa del tipo de modelo y la técnica de solución para minimizar los errores. Los modelos de simulación, por el contrario, proporcionan simulaciones por computadora de sistemas reales y son más realistas, particularmente para modelar sistemas dinámicos y/o probabilísticos como un aeropuerto internacional.

1.5 Elementos Estructurado para la toma de Decisiones.

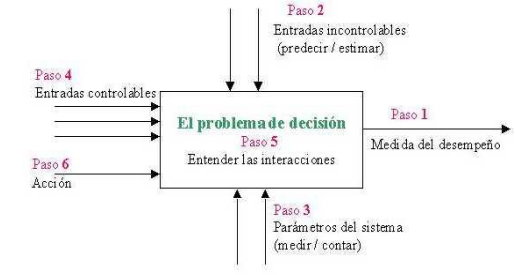

En el proceso de modelado de toma de decisiones, analizamos el efecto de presentar diferentes decisiones retrospectivamente, como si ya se hubieran tomado de acuerdo con varios cursos de acción. Esto requiere considerar la secuencia de pasos a la inversa. Por ejemplo, primero debemos considerar el resultado, que es el resultado de nuestra acción, como si la decisión ya se hubiera tomado bajo un curso de acción diferente. Las interacciones entre estos componentes están representadas por funciones matemáticas que representan relaciones de causa y efecto entre entradas, parámetros y el resultado. También hay grupos de restricciones que se aplican a cada componente, por lo que no deben tratarse por separado, dado que el modelo de un sistema representa los elementos que impactan el objetivo de una decisión, es crucial identificar los elementos más importantes. Estos elementos suelen estar determinados por el resultado deseado, que luego determina los insumos controlables.

Las entradas de un sistema se pueden clasificar como controlables o incontrolables, es esencial seleccionar cronogramas de revisión de modelos que sean lo suficientemente cortos para que los datos incontrolables o el conocimiento probabilístico que tenemos sobre ellos no cambien significativamente. El resultado de este proceso se conoce como medida del rendimiento del sistema, cuando el resultado de una decisión depende del curso de acción, modificamos aspectos de la situación problemática para lograr un cambio deseado en otro aspecto. Esto se puede lograr comprendiendo la interacción entre los componentes del problema. Un principio general en la toma de decisiones es que si algo no se puede medir, no se puede gestionar. Por lo tanto, medir el desempeño conduce a la mejora e informar que el desempeño acelera la mejora.

El Gráfico 1.4 ilustra el proceso estructurado de toma de decisiones en el contexto de IoT. Como se muestra en el diagrama de actividades mencionado anteriormente, el proceso de toma de decisiones consta de varios componentes. La medida de desempeño proporciona el nivel deseado de resultado, que es el objetivo de la decisión, identificar el objetivo es crucial para la identificación del problema. La principal tarea del tomador de decisiones es encontrar una solución que equilibre diferentes objetivos y seleccione el que tenga el mayor valor. Si es necesario, todos los demás objetivos deben incluirse como restricciones a satisfacer. El curso de acción representa la decisión final y la estrategia óptima para lograr el objetivo deseado, tomar una decisión implica seleccionar un curso de acción para perseguir el objetivo. El impacto de un curso de acción en el resultado depende de cómo se interrelacionan los insumos y parámetros del problema y cómo se relacionan con el resultado. Los aportes incontrolables provienen del entorno de quien toma las decisiones y a menudo crean problemas y restringen las acciones. Los parámetros son elementos constantes que cambian durante el horizonte temporal de la revisión de la decisión y definen parcialmente el problema.

Gráfico 1.4

Estructuración del Proceso de Toma de Decisiones.

Fuente: Carro, (2009).

Durante la década de 1950, se desarrolló en el prestigioso Instituto Tecnológico de Massachusetts (MIT) una metodología de sistemas revolucionaria llamada Dinámica de Sistemas. El cerebro detrás de este enfoque innovador fue Jay W. Forrester, un consumado ingeniero electrónico que previamente había hecho importantes contribuciones al campo de las memorias magnéticas. La participación de Forrester en el desarrollo del sistema SAGE, un sistema de alerta en tiempo real de vanguardia, lo llevó a reconocer el inmenso valor de un enfoque sistémico para comprender y controlar entidades complejas que surgen de la interacción entre humanos y máquinas. Impulsado por sus experiencias, Forrester pasó a desempeñar un puesto docente en la MIT Sloan School of Management.

Fue durante este tiempo que hizo una observación fascinante: notó la aparición de fenómenos de retroalimentación dentro de las empresas, que podían provocar oscilaciones muy parecidas a los servomecanismos que había estudiado anteriormente. Esta comprensión llevó a Forrester a idear Dinámica Industrial, una metodología revolucionaria que permitió la creación de modelos cibernéticos para simular procesos industriales. Lo que distinguió a estos modelos fue su capacidad única para simular la evolución temporal de estos sistemas con la ayuda de computadoras. Posteriormente, Forrester amplió su metodología para abordar problemas de planificación urbana, dando como resultado el nacimiento de System Dynamics. El impacto de la dinámica de sistemas creció exponencialmente en la década de 1970, especialmente después de que el influyente Club de Roma encargó a Forrester y su equipo estudiar los efectos del crecimiento demográfico y la actividad humana en un mundo con recursos limitados. Forrester encabezó la creación de un modelo mundial inicial, que sirvió de base para el innovador informe conocido como "Los límites del crecimiento".

Dirigida por D.L. Meadows y financiado por la Fundación Volkswagen, este informe arroja luz sobre los problemas apremiantes que enfrentó la humanidad y las consecuencias de nuestras acciones. Además, otro informe, titulado "La humanidad en el punto de inflexión", también se basó en System Dynamics y fue encargado por Mesarovic y Pestel. Los principios subyacentes de la dinámica de sistemas tienen sus raíces en las características inherentes de los sistemas sociales y las limitaciones de los propios seres humanos. Según Forrester, los sistemas como empresas, organizaciones, mercados y economías son cerrados y no lineales en su estructura. Se consideran cerrados porque las decisiones tomadas por los individuos dentro de estos sistemas tienen un efecto dominó que influye en las decisiones posteriores. Por ejemplo, si un director de marketing decide lanzar una campaña de marketing, el resultado de esa campaña afectará posteriormente a los procesos de toma de decisiones futuros.

Cuando una empresa promociona uno de sus productos, puede crear dificultades para otros productos dentro de la misma empresa. Esto puede dar lugar a comportamientos indeseables, como oscilaciones, especialmente si los efectos de la promoción se manifiestan con retraso. Por otro lado, hay efectos de refuerzo que ocurren cuando una empresa es la primera en ingresar a un nuevo mercado y obtiene una ventaja competitiva a través de la innovación y relaciones sólidas con los clientes. Estos circuitos de retroalimentación desempeñan un papel crucial en la configuración del sistema general, dentro de un mismo sistema, puede haber múltiples bucles de retroalimentación operando a diferentes velocidades, dependiendo del tiempo que tarda una causa en producir un efecto, las conexiones entre las variables de un sistema suelen ser no lineales, lo que significa que los efectos se multiplican en lugar de simplemente sumarse.

El comportamiento de un sistema, incluida la participación de mercado, la ventaja comparativa y las relaciones con los competidores, está determinado por sus entidades estructurales y las relaciones causales entre ellas. Este comportamiento puede ser muy complejo y dinámico, incluso en estructuras aparentemente simples. Ejemplos de comportamientos tan complejos incluyen el crecimiento en forma de S, el crecimiento exponencial, la reacción exagerada, el crecimiento y el colapso, y la oscilación, todos los cuales pueden analizarse examinando la estructura subyacente.

1.6 Las limitaciones de la Naturaleza Humana.

Recientemente se ha puesto énfasis en el pensamiento sistémico, que puede verse como un lenguaje utilizado para abordar eficazmente las complejidades e interdependencias que los administradores encuentran a diario. Frente a estos sistemas complejos, los individuos se esfuerzan por comprender su comportamiento para poder dar una explicación válida. Sin embargo, nuestras capacidades cognitivas son principalmente adecuadas para un mundo estable que carece de cambios rápidos, donde principalmente consideramos sólo lo que está cerca en el tiempo y el espacio. En consecuencia, a menudo cometemos errores de juicio al descuidar la relevancia de variables y conexiones que están distantes en el tiempo o remotas en el espacio. Esta perspectiva limitada conduce a modelos mentales y a una toma de decisiones incompleta que produce efectos secundarios inesperados e incluso molestos.

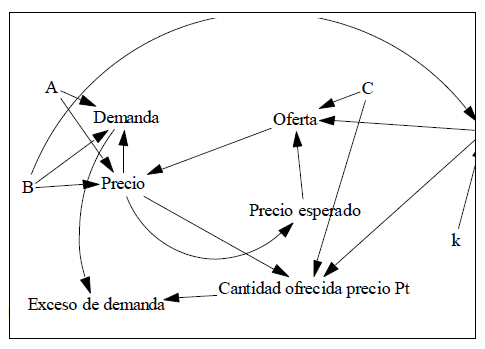

1.7 Diagramas Causales o de Lazos.

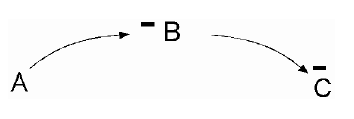

Un diagrama de bucle causal comprende cuatro elementos esenciales: variables, vínculos entre ellas, signos de los vínculos (que demuestran interconexiones) y signos del bucle (que indican el comportamiento del sistema). Al adoptar una perspectiva sistémica, se pueden analizar los problemas para identificar las fuerzas subyacentes que impulsan el comportamiento observado, los diagramas causales juegan un papel crucial en el estudio de sistemas dinámicos de dos maneras. En primer lugar, durante la fase de desarrollo del modelo, sirven como esbozo inicial de la hipótesis causal. En segundo lugar, ayudan a simplificar la ilustración del modelo. En ambos casos, estos diagramas permiten a los analistas comunicar de manera efectiva la comprensión estructural del sistema según el modelo. Ampliando el trabajo realizado por Forrester, el concepto de diagramas causales se utiliza ampliamente en el modelado de sistemas.

Estos diagramas, que se dibujan utilizando diversos programas informáticos, permiten la simulación y predicción de los resultados del modelo con una variación mínima en su representación. El proceso de construcción de vínculos causales implica varios pasos. En primer lugar, las variables se crean y nombran en consecuencia. A continuación, se dibujan enlaces para establecer conexiones. Luego se nombra el bucle y, finalmente, se recorre para comprender sus implicaciones. Los diagramas de vínculos causales pueden verse como oraciones construidas identificando variables clave e indicando sus relaciones causales a través de vínculos. Estos vínculos están representados por flechas, que se originan en variables independientes y terminan en variables dependientes. Al interconectar estos vínculos, se puede crear una narrativa coherente para abordar temas o problemas específicos. Para ilustrar más estos conceptos, consideremos un ejemplo tomado de Study Notes in System Dynamics de Michael R. Goodman, cap. 1. Los sistemas dinámicos se basan en las interacciones de bucles de retroalimentación, y los diagramas de flujo y los diagramas causales sirven como representaciones visuales de estas estructuras cíclicas antes de su posterior desarrollo en redes consistentes con tasas, niveles y elementos auxiliares.

Al diagramar bucles causales, los modeladores pueden obtener una comprensión conceptual de los sistemas del mundo real en términos de bucles de retroalimentación.

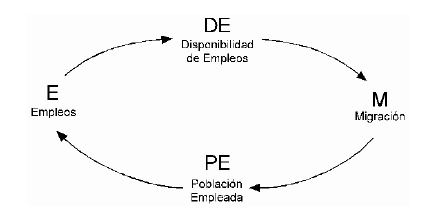

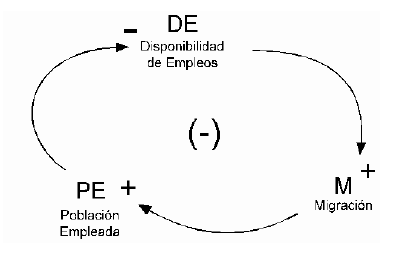

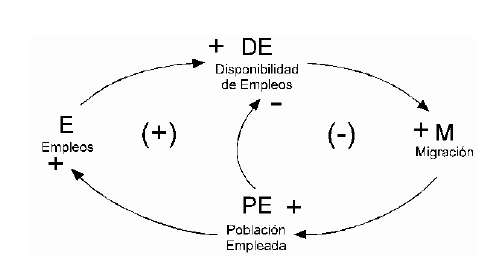

1.8 Modelo Migración Población, Migración, Empleo.

Diagrama 1.1

Diagrama Causal

La relación entre la migración y la disponibilidad de empleos en DE es compleja e involucra varios ciclos de retroalimentación. La disponibilidad de empleos en DE atrae inmigrantes a la ciudad, lo que a su vez aumenta la población de empleados. Este crecimiento demográfico conduce a la absorción de empleos disponibles, pero también crea una demanda de más servicios urbanos y, en última instancia, resulta en la expansión de empleos tanto E como DE. El aumento del número de puestos de trabajo disponibles en la ciudad también tiene un impacto en la disponibilidad de puestos de trabajo DE. A medida que se crean más puestos de trabajo, también aumenta la disponibilidad de puestos de trabajo en DE. Esto significa que cuantas más oportunidades laborales haya en la ciudad, más opciones habrá para las personas que buscan empleo en el sector DE.

La migración y la disponibilidad de empleos DE están interconectadas en un sistema donde una afecta a la otra. Esta relación puede explicarse a través de una serie de hipótesis causales que resaltan los circuitos de retroalimentación involucrados en el funcionamiento urbano. En el largo plazo, la población ocupada en la ciudad demanda más servicios urbanos. Esto se debe a que a medida que hay más personas empleadas, necesitan acceso a diversos servicios como transporte, atención médica y educación. El aumento de la demanda de estos servicios conduce a la expansión del número total de empleos E disponibles en la ciudad. Con más gente en la fuerza laboral, los empleos disponibles en la ciudad comienzan a ser absorbidos. Esto significa que a medida que la población crece, el número de oportunidades laborales disminuye porque están siendo ocupadas por los recién llegados. A medida que estos inmigrantes llegan, contribuyen al crecimiento de la población de empleados en la ciudad. Este aumento de población es el resultado de que los recién llegados se unen a la fuerza laboral y se suman al número total de empleados en la ciudad. La primera hipótesis afirma que la disponibilidad de empleos en DE conduce a una afluencia de inmigrantes hacia la ciudad, esto significa que cuando hay oportunidades laborales en la ciudad, es más probable que la gente migre allí en busca de empleo. El proceso de creación de este diagrama paso a paso proporcionará una explicación detallada de cómo representar ciclos o bucles de manera efectiva. Para diagramar con precisión la estructura de un ciclo y determinar su polaridad, es necesario establecer conexiones entre todos los pares de variables pertinentes.

1.9 Relaciones Causa-Efecto Modelos de Aplicación.

Las variables en este contexto son las siguientes: Empleos (E), que se refiere al número total de vacantes y puestos de trabajo cubiertos en el área urbana; Disponibilidad de Empleo (DE), que representa el número de puestos de trabajo vacantes; Migración (M), que significa la migración de la población trabajadora al área urbana; y Población Ocupada (PE), que indica la población ocupada residente en la zona.

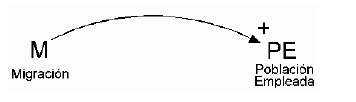

Otro ejemplo de relación positiva involucra las variables Migración (M) y Población Ocupada (PE). Representamos esta relación de la misma manera que la relación DE-M anterior. El Diagrama 1.2 ilustra la relación M-PE, donde un aumento en la tasa de migración (M) conduce a un aumento en el número de personas empleadas, expandiendo así la población residente empleada. La flecha sirve como indicador de la dirección de la influencia, mientras que el signo más (+) o menos (-) indica el tipo de influencia. Cuando hay un aumento en la Disponibilidad de Empleo (DE), se produce un aumento en la Migración (M). Por lo tanto, la relación entre las dos variables se indica con un signo "+", que indica una correlación positiva. Para aplicar esta definición, solo consideramos pares de variables adyacentes entre sí. De manera similar, podemos usar esta definición con ligeros ajustes para determinar la polaridad de circuitos cerrados de retroalimentación. En un sentido más amplio, si todas las demás variables permanecen constantes, un cambio en una variable da como resultado un cambio en la misma dirección para la segunda variable, en comparación con su valor anterior. Esto se conoce como una relación positiva entre las variables.

Diagrama 1.2

Disponibilidad de Empleos Positivo Lazo Migración

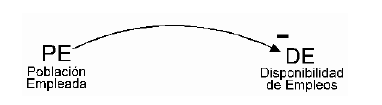

Una relación negativa se indica con un signo "-" y se caracteriza por la ocurrencia de un cambio en una variable que resulta en un cambio en la dirección opuesta en la segunda variable. Esta relación negativa se representa visualmente en el diagrama 1.3

Diagrama 1.3

Población Empleada Positivo. Lazo Migración

Diagrama 1.4

Disponibilidad de Empleos Negativo. Lazo Población Empleada-

Vale la pena señalar que cuando dos pares de relaciones negativas se conectan, en realidad crean una relación positiva a lo largo de toda la cadena. En este caso, las variables A, B y C están encadenadas negativamente, como se muestra en el Diagrama. Cuando la variable A aumenta, provoca una disminución en B, lo que a su vez conduce a un aumento en la variable C. Como resultado, se considera que la cadena de A a C tiene una relación positiva. Los diagramas 1.3 y 1.4 presentan un supuesto causal sobre la relación entre la población residente ocupada y la disponibilidad de empleos en un área urbana. Según la Figura 4, un aumento en el número de residentes empleados eventualmente conducirá a una disminución en la disponibilidad de empleo. Esto se debe a que a medida que nuevos trabajadores ingresan a la ciudad, llenan los puestos de trabajo disponibles, reduciendo así el número total de oportunidades laborales. Por el contrario, si la población de trabajadores residentes comienza a disminuir, se puede suponer que habrá más puestos de trabajo disponibles. Por lo tanto, cualquier aumento o disminución de la población ocupada dará como resultado el cambio opuesto en la disponibilidad de empleo.

Diagrama 1.5

Los Causales.

Diagrama 1.6

Lazo Causal Simple.

Los diagramas 1.5 y 1.6 muestra un circuito de retroalimentación negativa, indicado por el signo "-" en el centro del ciclo ilustran las relaciones interconectadas entre los pares DE, M y PE. Para determinar la polaridad del ciclo completo, debemos considerar las consecuencias de un cambio hipotético en la variable del ciclo. El aumento de la disponibilidad laboral se ve reforzado por la cadena positiva entre PE y E. Para determinar la polaridad del nuevo ciclo, podemos examinar el efecto de un aumento significativo en la disponibilidad laboral dentro de ese ciclo, ignorando todas las demás cadenas fuera de él. Este aumento resultaría en una migración hacia el área urbana, lo que llevaría a un aumento de la Población Ocupada. Esto, a su vez, eventualmente aumentaría el número de empleos básicos, mejorando así la disponibilidad de empleo. Consideremos un escenario en el que hay un aumento repentino en la disponibilidad de empleo. Este aumento de ED atraería a más personas a la ciudad, lo que resultaría en un aumento de la Población Ocupada (PE). Entonces, la DE aumenta la PE, un aumento de la Población Ocupada conduce a una disminución de la Disponibilidad de Empleo.

Las causas internas que inicialmente aumentaron la DE han desencadenado una serie de reacciones y ajustes internos dentro del sistema. Estos cambios crean presiones que se oponen a cualquier cambio adicional en DE. Por lo tanto, el ciclo tiende a mantener un valor u objetivo fijo para la DE, a pesar de que las influencias externas empujan en la dirección opuesta. Cuando un sistema consta de múltiples ciclos, es necesario determinar la polaridad de cada ciclo de forma aislada. Esto implica suponer que todas las demás variables fuera del ciclo (y dentro de él) permanecen constantes. Cada ciclo tendrá su propia polaridad. Para determinar la polaridad de un ciclo, el método sugerido es comenzar desde un punto del sistema con una suposición, como por ejemplo asumir que hay crecimiento en ese punto.

Luego, recorre todo el ciclo y observa el efecto al regresar, si el efecto va en aumento, el ciclo es positivo; si no, es negativo, si el efecto recibido es del mismo signo, el ciclo es positivo; si es de signo contrario, el ciclo es negativo. Cuando un circuito de retroalimentación responde a un cambio en una variable en dirección opuesta a la perturbación original, lo llamamos ciclo negativo. Por otro lado, cuando el ciclo responde reforzando la perturbación original, se le denomina ciclo positivo, los diagramas 1.6 presenta una cadena positiva entre la Población Ocupada (PE) y el Empleo (E). Esta cadena supone que un aumento de la Población Ocupada eventualmente conducirá a un aumento de los Empleos, debido al aumento de la demanda de diversos servicios como vivienda, construcción, etc. El modelo ahora consta de dos ciclos cerrados: el conocido ciclo negativo compuesto por DE , M y PE; y un nuevo ciclo positivo (externo) que involucra las cuatro variables, la introducción de esta nueva cadena no afecta la polaridad del ciclo compuesto por DE, M y PE.

Diagrama 1.7

Dos Ciclos.

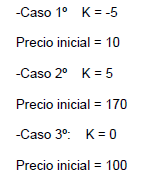

1.10 Modelo de la Oferta con retardo.

Este modelo particular se puede aplicar a mercados donde el proceso de producción es largo y el producto no se puede almacenar. En este modelo, asumimos que la cantidad demandada del producto en un momento dado es una función lineal de su precio, expresado como Demanda = A - B * Precio. Por otro lado, la cantidad ofrecida por los productores depende del precio que inicialmente esperaban recibir por el producto, representado como Oferta = C + E * Precio esperado. Es importante señalar que en este escenario el producto no es almacenable, por lo que los productores aceptarán el precio máximo que los consumidores estén dispuestos a pagar para agotar su producción, incluso si difiere de sus expectativas iniciales, los productores forman sus expectativas de precios basándose en el precio de mercado del período anterior, adoptando un enfoque más ingenuo.

Es necesario analizar la tendencia de los precios en un lapso de 100 años en las tres situaciones. Esto implica examinar diferentes períodos de tiempo y comparar la cantidad demandada por los consumidores con la cantidad que los productores habrían ofrecido si hubieran tenido conocimiento del precio vigente en el momento de tomar la decisión de producción.

CAPÍTULO II

EL PROCESO DE TOMA DE DECISIONES ANTE SITUACIONES QUE IMPLICAN RIESGO E INCERTIDUMBRE.

2. EL RIESGO.

Para ilustrar la distinción entre modelos probabilísticos y deterministas, consideremos el pasado y el futuro, si bien no podemos alterar el pasado, cualquier acción que emprendamos en el presente tiene el potencial de influir y dar forma al futuro, aunque sea incierto. Los directivos suelen priorizar la configuración del futuro en lugar de insistir en acontecimientos pasados. Los sistemas pueden permanecer sin cambios o sufrir cambios con el tiempo aquellos que permanecen estáticos se conocen como sistemas deterministas, mientras que la mayoría de las organizaciones que encontramos son sistemas dinámicos que evolucionan constantemente, cuando un sistema sigue un patrón típico de desarrollo, nos referimos a él como si tuviera un patrón de comportamiento.

Que un sistema sea estático o dinámico depende del marco temporal de estudio elegido y de las variables en las que se centra, el horizonte temporal se refiere al período específico en el que se analiza el sistema, mientras que las variables son los valores cambiantes dentro del sistema. Anteriormente, analizamos cómo los sistemas se componen de varias partes que trabajan juntas para lograr un objetivo específico. Las relaciones entre estas partes son cruciales para determinar la funcionalidad y el funcionamiento generales del sistema. De hecho, estas relaciones suelen tener más importancia que las propias partes individuales. Cuando los sistemas se construyen utilizando sistemas más pequeños, se les denomina subsistemas. La probabilidad juega un papel importante en el proceso de toma de decisiones, ya que ayuda a navegar situaciones con información limitada y un alto grado de incertidumbre de hecho, es raro tener acceso a todos los datos necesarios a la hora de tomar decisiones, la probabilidad es un concepto crucial que los gerentes deben considerar cuando se enfrentan a la incertidumbre.

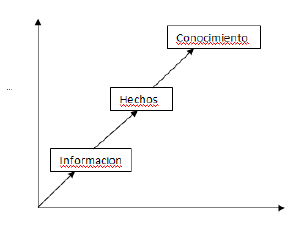

El conocimiento es la acumulación de lo que entendemos y comprendemos. Es la base sobre la que construimos nuestra comprensión del mundo. La información, por otro lado, es el medio a través del cual se comunica y comparte el conocimiento, es la transferencia de conocimiento de una entidad a otra. Los datos, a menudo denominados información bruta, no se consideran conocimiento en sí mismos, es la etapa inicial en el proceso de transformación hacia el conocimiento, el viaje de los datos al conocimiento implica varios pasos. Primero, los datos se convierten en información cuando se vuelven relevantes y útiles en el contexto de la toma de decisiones. Luego, esta información se refina y verifica aún más y, en última instancia, se convierte en hechos cuando está respaldada por evidencia y datos concretos. La información se puede clasificar en dos formas distintas: explícita y tácita. La información explícita está estructurada y puede explicarse y comprenderse fácilmente. Puede transmitirse a través de instrucciones, directrices o manuales claros. Por el contrario, la información tácita es más difícil de articular, ya que a menudo se basa en experiencias personales, intuición o emociones. Es subjetivo y no fácilmente transferible, lo que hace que su explicación sea inconsistente e imprecisa. En resumen, conocimiento e información son conceptos estrechamente entrelazados. El conocimiento es lo que sabemos y entendemos, mientras que la información es el medio a través del cual se comunica el conocimiento. La transformación de datos en conocimiento implica varias etapas, incluida la conversión de datos en información y de información en hechos.

El conocimiento no es estático sino dinámico, influenciado por incertidumbres y expresado con cierto grado de confianza, en última instancia, el conocimiento se vuelve valioso cuando se utiliza de manera efectiva en los procesos de toma de decisiones, lo que conduce a mejores resultados y avances. En cualquier intercambio de conocimiento intervienen dos partes: el emisor y el receptor. El remitente es responsable de hacer accesible a otros su conocimiento privado transformándolo en información. Esta comunicación de información puede adoptar diversas formas, como comunicación verbal o escrita, representaciones visuales o incluso señales no verbales.

El conocimiento realmente evoluciona hacia su forma completa cuando se aplica con éxito en los procesos de toma de decisiones, es a través de la utilización de hechos e información que el conocimiento se convierte en una herramienta poderosa que ayuda a completar con éxito diversas tareas y desafíos, es importante señalar que el conocimiento no se basa únicamente en hechos. El conocimiento instrumental, que es conocimiento práctico utilizado en los procesos de toma de decisiones, a menudo se expresa con cierto grado de confianza estadística. Esto significa que el conocimiento no es absoluto ni definitivo sino que está influenciado por diversos factores e incertidumbres.

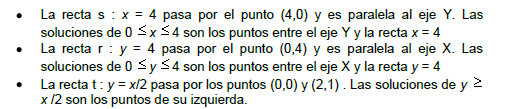

En un entorno incierto, la probabilidad de tomar "buenas decisiones" aumenta cuando se tiene acceso a "buena información". El grado de estructuración en el proceso de Gestión del Conocimiento contribuye a la disponibilidad de información tan valiosa, el diagrama refuerza la noción de que a medida que mejora la precisión de un modelo estadístico, la toma de decisiones también experimenta un aumento correspondiente en efectividad. El diagrama anterior muestra la correlación entre la precisión de un modelo estadístico y el nivel de mejora en la toma de decisiones. Destaca el papel crucial de las estadísticas empresariales en nuestra sociedad, la estadística surgió de la necesidad de establecer una base sistemática para el conocimiento, lo que implicaba estudiar leyes de probabilidad, medir propiedades y analizar relaciones de datos.

Gráfico 2.1

Exactitud del Modelo Estadístico.

Niveles de mejoras en la toma de Decisiones.

2.1. De los datos a un conocimiento decisivo.

La probabilidad juega un papel crucial en tales situaciones, actuando como sustituto de la certeza y el conocimiento completo. Los modelos probabilísticos se basan en aplicaciones estadísticas que ayudan a evaluar eventos o factores incontrolables y evaluar los riesgos asociados con la toma de decisiones. Originalmente, el campo de la estadística tenía como objetivo recabar información para el Estado. Curiosamente, el término "estadística" no tiene raíces griegas o latinas, sino que proviene de la palabra italiana para estado. Por otra parte, la probabilidad tiene una historia mucho más larga. Sus raíces se remontan al verbo "probar", que implica el acto de descubrir información que no se obtiene ni se comprende fácilmente.

De hecho, la palabra "prueba" comparte el mismo origen, proporcionando los detalles necesarios para comprender lo que se considera verdadero. Los modelos probabilísticos pueden compararse con un juego, en el que la toma de decisiones se guía por resultados anticipados. Este cambio de un enfoque determinista a uno probabilístico implica el empleo de métodos estadísticos subjetivos para la estimación, prueba y predicción. Dentro de estos modelos, el concepto de riesgo se refiere a la presencia de incertidumbre, cuya distribución de probabilidad está bien definida. En consecuencia, realizar una evaluación de riesgos implica un examen de los resultados potenciales de las decisiones, junto con sus probabilidades asociadas.

Un ejemplo de sabiduría en acción es la creación de software estadístico que no sólo sea técnicamente avanzado sino que también tenga un propósito práctico. Se ha observado que la llegada de Internet y su amplia popularidad nos proporciona grandes cantidades de información, pero no nos brinda la sabiduría para comprender y utilizar esa información de manera efectiva.

Este paso implica limpiar y preparar los datos para el análisis, identificar cualquier valor atípico o error y seleccionar métodos estadísticos apropiados para analizar los datos. Las técnicas de análisis estadístico pueden variar según la naturaleza de los datos y los objetivos del proceso de toma de decisiones. Las técnicas estadísticas comunes incluyen estadística descriptiva, estadística inferencial, análisis de regresión y prueba de hipótesis. El proceso de toma de decisiones estadísticas se refiere a un enfoque sistemático utilizado por individuos u organizaciones para tomar decisiones informadas basadas en análisis estadístico e interpretación de datos. Este proceso implica varios pasos que están diseñados para garantizar que las decisiones se tomen de manera lógica y objetiva, teniendo en cuenta varios factores y minimizando el potencial de sesgos o errores. Una vez analizados los datos, el siguiente paso es interpretar los resultados.

Esto implica sacar conclusiones de los datos y comprender las implicaciones de los hallazgos. Es importante considerar las limitaciones e incertidumbres asociadas con los datos y el análisis, así como cualquier posible sesgo o factor de confusión que pueda haber influido en los resultados. Finalmente, una vez que se ha tomado una decisión, es importante monitorear y evaluar los resultados. Esto implica evaluar la efectividad de la decisión y determinar si es necesario realizar algún ajuste o modificación. Al monitorear y evaluar los resultados, las personas u organizaciones pueden aprender de sus decisiones y mejorar su proceso de toma de decisiones en el futuro, una vez definido el problema, entonces es necesario iniciar la captación de los datos requeridos.

En este sentido, se recopila información y datos de diversas fuentes, que pueden incluir encuestas, experimentos, observaciones o bases de datos existentes. Los datos recopilados deben ser relevantes y representativos del problema en cuestión, asegurando que proporcionen una comprensión integral y precisa de la situación. El primer paso en el proceso de toma de decisiones estadísticas es definir claramente el problema u objetivo en cuestión. Esto implica identificar la decisión específica que se debe tomar y comprender el contexto y los antecedentes de la situación. Al definir claramente el problema, los individuos u organizaciones pueden centrar sus esfuerzos en recopilar los datos relevantes y realizar el análisis necesario, el proceso de toma de decisiones estadísticas es un enfoque sistemático y lógico que se utiliza para tomar decisiones informadas basadas en el análisis estadístico y la interpretación de datos.

Al seguir este proceso, las personas u organizaciones pueden garantizar que las decisiones se tomen de manera racional y objetiva, lo que conducirá a resultados más efectivos y exitosos. Con base en la interpretación de los resultados, el siguiente paso es tomar una decisión. Esto implica sopesar la evidencia y considerar las implicaciones de diferentes opciones o cursos de acción. Es importante considerar los riesgos y beneficios potenciales de cada opción, así como cualquier consideración ética o legal.

2.2 Toma de Decisiones Estadística.

A diferencia de los procesos deterministas de toma de decisiones como la optimización lineal, que implican resolver un conjunto de ecuaciones, los sistemas paramétricos de ecuaciones y la toma de decisiones bajo pura incertidumbre implican una mayor cantidad de variables que son más difíciles de cuantificar y verificar, esta complejidad se ve contrarrestada por el hecho de que es más fácil de comprender que un evento observado, lo que hace que su resolución sea más manejable y eficiente en términos de tiempo, el modelo se puede aplicar a problemas similares varias veces y también se puede adaptar y modificar según sea necesario. En comparación, la gama de métodos probabilísticos y estadísticos disponibles para analizar la toma de decisiones en condiciones de incertidumbre se ha ampliado significativamente y se ha vuelto más eficaz.

Los tomadores de decisiones a menudo encuentran importantes lagunas de información. La evaluación de riesgos sirve para cuantificar la diferencia entre lo que se sabe y lo que se requiere para tomar una decisión óptima. Los modelos probabilísticos sirven como salvaguardias contra la incertidumbre adversa y la explotación de dicha incertidumbre. El origen de la teoría de la decisión para la toma de decisiones surge del concepto de función de utilidad de pago. Este propone que las decisiones se deben tomar calculando la utilidad y probabilidad de varias opciones dentro de un rango, estableciendo estrategias para una toma de decisiones efectiva. Fundamentalmente, la toma de decisiones implica combinar información sobre probabilidades con deseos e intereses. Este enfoque, que trata las decisiones como si fueran apuestas, sirve como base de la teoría de la decisión. Requiere sopesar el valor de un determinado resultado frente a su probabilidad de ocurrencia. En el ámbito de los modelos probabilísticos, a menudo se los compara con juegos, donde las acciones se basan en resultados anticipados.

El cambio de modelos deterministas a probabilísticos implica la utilización de técnicas estadísticas subjetivas para la estimación, prueba y predicción. Dentro de estos modelos, el riesgo se refiere a la incertidumbre con una distribución de probabilidad conocida. Por lo tanto, la evaluación de riesgos implica un estudio integral que determina los resultados potenciales de las decisiones junto con sus respectivas probabilidades. Cuando entra en el proceso, asume el papel de sustituto de la certeza, llenando los vacíos del conocimiento completo. Los modelos probabilísticos se basan en aplicaciones estadísticas que evalúan eventos y factores incontrolables, así como también evalúan los riesgos asociados con la toma de decisiones. Inicialmente, las estadísticas tenían como objetivo recopilar información para el Estado, y el término en sí proviene de la palabra italiana "bienestar". Por otro lado, la probabilidad tiene una historia más larga, derivada del verbo "probar", que denota la búsqueda de comprensión y obtención de conocimiento. La palabra “prueba” comparte el mismo origen, aportando los detalles necesarios para comprender lo que se considera verdadero.

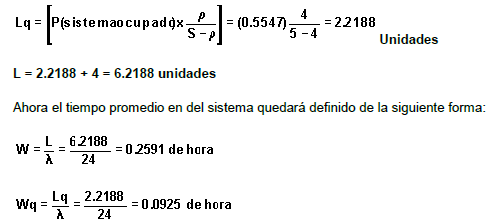

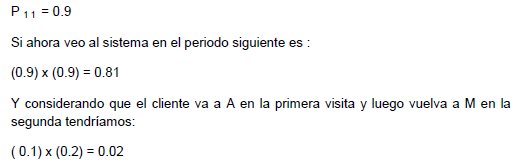

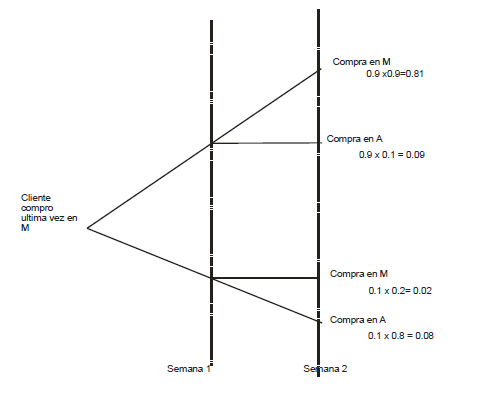

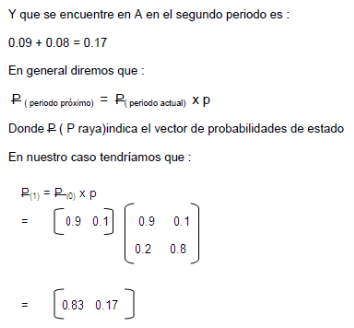

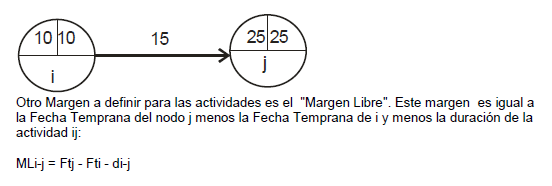

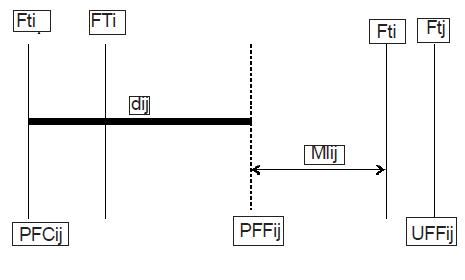

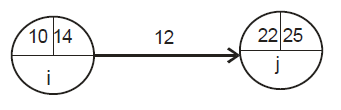

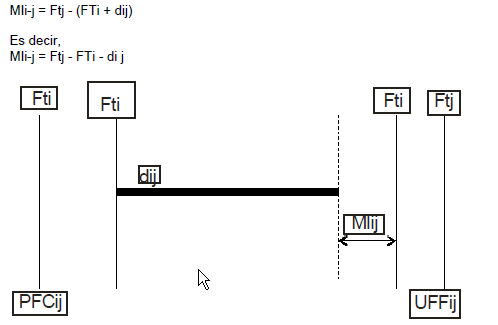

Los desafíos de la toma de decisiones se ejemplifican aún más por la complejidad de las alternativas disponibles. Quienes toman decisiones deben lidiar con información limitada al considerar las implicaciones de un solo curso de acción, en muchos casos, también deben prever y comparar las implicaciones de múltiples cursos de acción. Además, a menudo entran en juego factores desconocidos y el resultado rara vez es seguro. A menudo, el resultado depende de las reacciones de otros individuos que tal vez ni siquiera sean conscientes de sus propias acciones. En consecuencia, no es sorprendente que a veces los tomadores de decisiones retrasen sus decisiones el mayor tiempo posible o tomen decisiones sin considerar plenamente todas las implicaciones.